Языковые модели имеют произвел революцию различных областях с их расширенными возможностями, оставляя многих людей с такими вопросами, как использование Google MusicLM и моделей GPT OpenAI, в том числе ЧатGPT и Кодекс, сыграли немалую роль в этом разрушении. Эти модели имеют возможность эффективно генерировать текст и код на основе данной подсказки. Тренировался на обширные наборы данныхих можно применять к многочисленным задачам обработки естественного языка (NLP), таким как анализ настроений, системы чат-ботов, обобщение, машинный перевод, и классификация документов.

Хотя эти модели имеют свои ограничения, они предлагают взгляд на потенциал языковых моделей понимать языки и разрабатывать приложения, которые могут улучшить человеческую жизнь. Хотя существуют опасения относительно их способность заменить людей в различных областях основной идеей является повышение производительности и предоставление новых способов изучения и понимания языка в целом.

Данный Фундаментальная роль языка в человеческой цивилизации, становится необходимым создавать языковые модели, которые могут декодировать текстовые описания и выполнять такие задачи, как генерация текста, изображений, аудио и даже музыки. В этой статье мы сосредоточимся в первую очередь на модели музыкального языкапохожие на такие модели, как ЧатGPT и Далл-Э, но вместо создания текста или изображений, они созданы для создания музыки.

Музыка – сложный и динамичный вид искусства. Он включает в себя оркестровку нескольких музыкальных инструментов, которые гармонируют для создания контекстуальный опыт. От отдельных нот и аккордов до речевых элементов, таких как фонемы и слоги, музыка включает в себя широкий спектр компонентов. Разработка математическая модель способный извлекать информацию из такой разнообразный набор данных является грандиозной задачей. Однако, как только такая модель создана, она может генерировать реалистичный звук, аналогичный тому, что могут воспроизводить люди.

Имея все это в виду, давайте углубимся в основную концепцию моделей музыкального языка и изучим, как они позволяют создавать музыку. Между тем, если вы заинтересованы в повышении уровня своей музыкальной игры, вы также можете узнать, как использовать Discord Soundboard и добавлять в нее новые звуки.

Понимание моделей музыкального языка и как использовать Google MusicLM

MusicLM использует различные методы машинного обучения, таких как глубокое обучение и обработка естественного языка, для анализа данных и выявления скрытых представлений, которые облегчают создание музыки. Эти модели используют наборы музыкальных данных для извлечения информации, выявления закономерностей и изучения широкого спектра музыкальных стилей и жанров.

MusicLM может автоматизировать ряд задач, в том числе написание музыкальных партитур анализируя существующую музыку, рекомендации новых аккордовых последовательностейили даже создание новых звуков. В конечном счете, это может ввести новые формы музыкального выражение и креативность, служит ценным инструментом для повышения навыков музыкантов и облегчения музыкального образования.

Представляем Google MusicLM

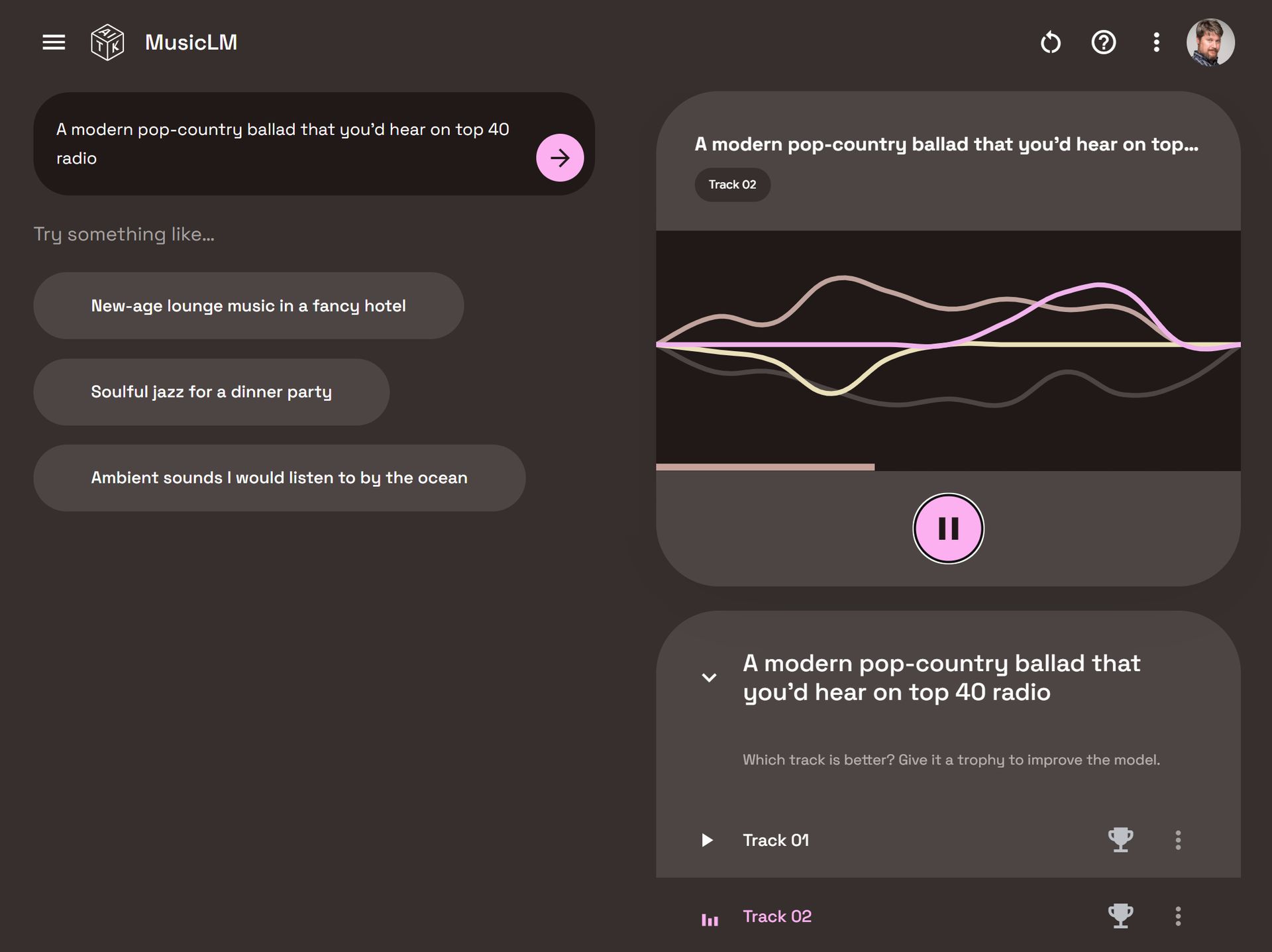

Google MusicLM — это специальная языковая модель, разработанная специально для создания музыки на основе текстовых описаний. Например, предоставив подсказку типа «успокаивающая гитарная мелодия в риффе 6/8», модель может воспроизвести соответствующую музыку.

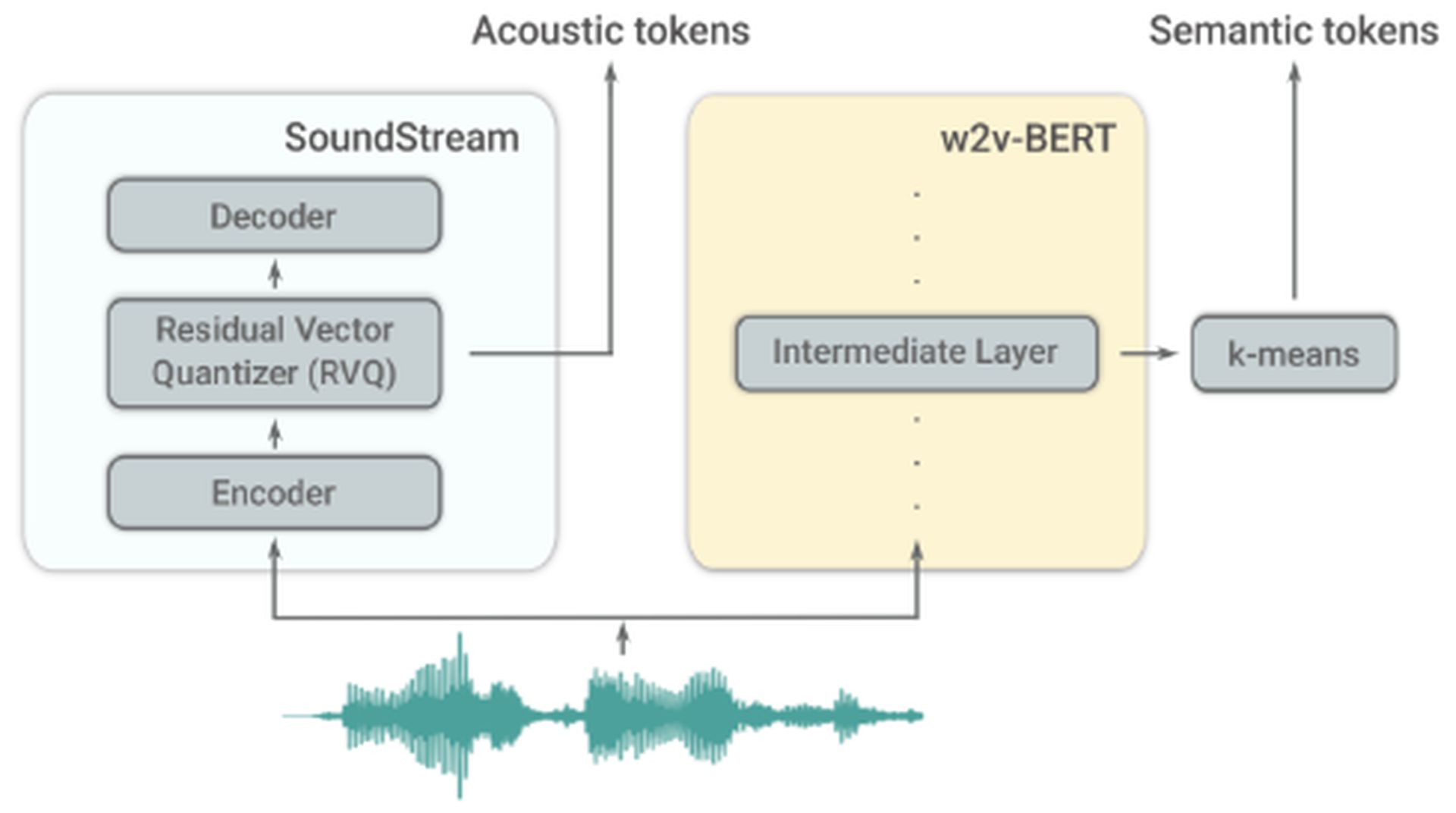

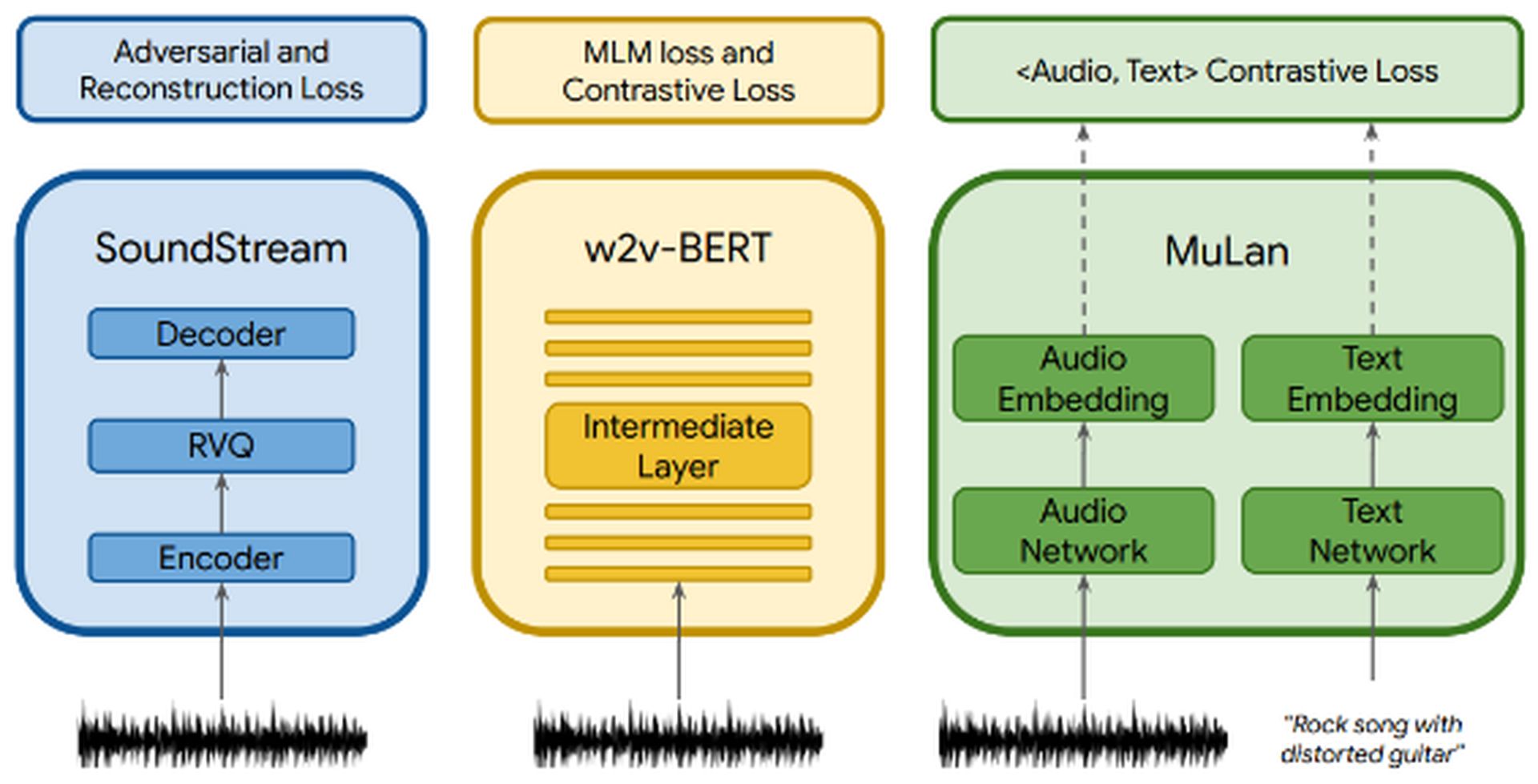

MusicLM опирается на АудиоЛМ, другая языковая модель разработано Google. AudioLM фокусируется на создании высокое качество и понятный речь и продолжение фортепианной музыки. Это достигается путем преобразования входного аудио в серию дискретных токенов и создание звуковых последовательностей с долгосрочной согласованностью. AudioLM использует два токенизатора: токенизатор SoundStream, который производит акустические токены, и токенизатор w2v-BERT, который генерирует семантические токены. Эти токенизаторы играют решающую роль в извлечении информации.

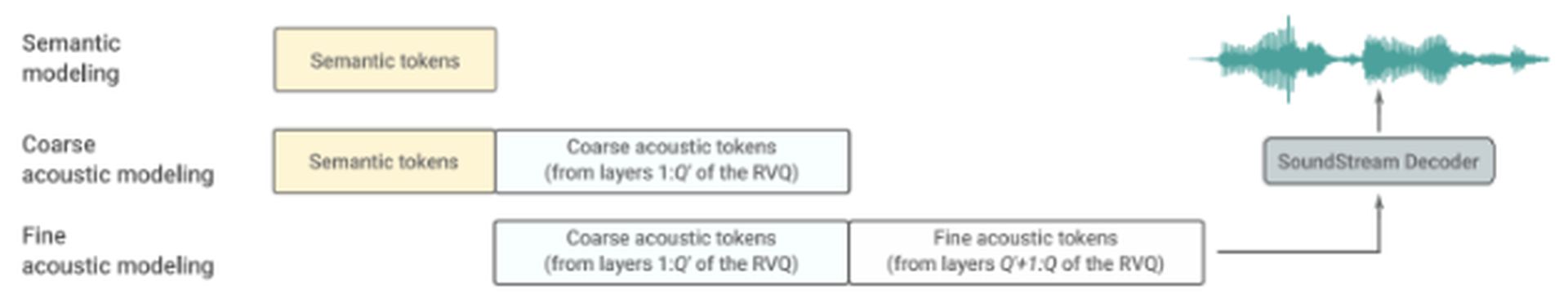

AudioLM состоит из трех иерархических ступеней:

- Семантическое моделирование: На этом этапе основное внимание уделяется фиксации долгосрочной структурной согласованности. Он извлекает высокоуровневую структуру входного сигнала.

- Грубое акустическое моделирование: Здесь модель создает акустические токены, которые затем объединяются или обусловливаются семантическими токенами.

- Тонкое акустическое моделирование: Окончательному звуку на этом этапе придается больше глубины, что включает в себя обработку грубых акустических токенов с тонкими акустическими токенами. Декодер SoundStream использует эти акустические маркеры для воссоздания формы волны.

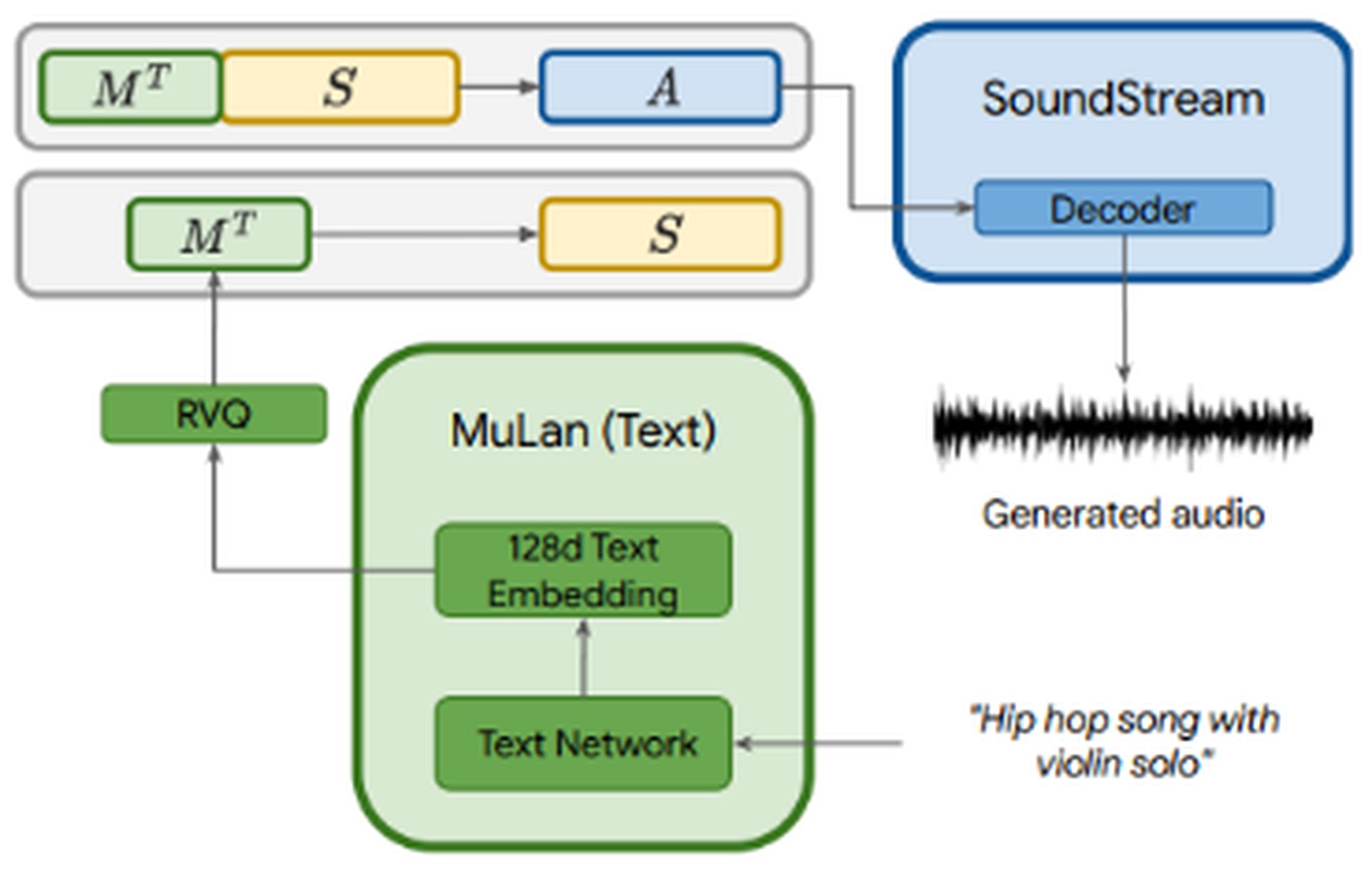

MusicLM использует AudioLM многоэтапное авторегрессионное моделирование как его порождающая составляющая, а также включающая в себя кондиционирование текста. Аудиофайл проходит через три компонента: SoundStream, w2v-BERT, и МуЛан. SoundStream и w2v-BERT обрабатывают и размечают входной аудиосигнал, а MuLan представляет собой совместную модель встраивания музыки и текста. МуЛан состоит из две встраиваемые башнипо одному на каждую модальность (текст и аудио).

В то время как звук подается на все три компонента, текстовое описание загружается только в MuLan. Вложения MuLan квантуются, чтобы обеспечить стандартизированное представление на основе дискретных токенов как для сигнала обработки, так и для звука. Затем выходные данные MuLan передаются в этап семантического моделирования, где модель изучает сопоставление звуковых токенов с семантическими токенами. Последующий процесс напоминает AudioLM.

MusicLM, основанный на AudioLM и MuLan, предлагает три ключевых преимущества:

- Генерация музыки на основе текстовые описания.

- Включение входных мелодий для расширения функциональности. Например, предоставив напевающую мелодию и поручив MusicLM преобразовать ее в гитарный рифф, модель может сгенерировать желаемый результат.

- Генерация длинных последовательностей для любого музыкального инструмента.

Набор данных

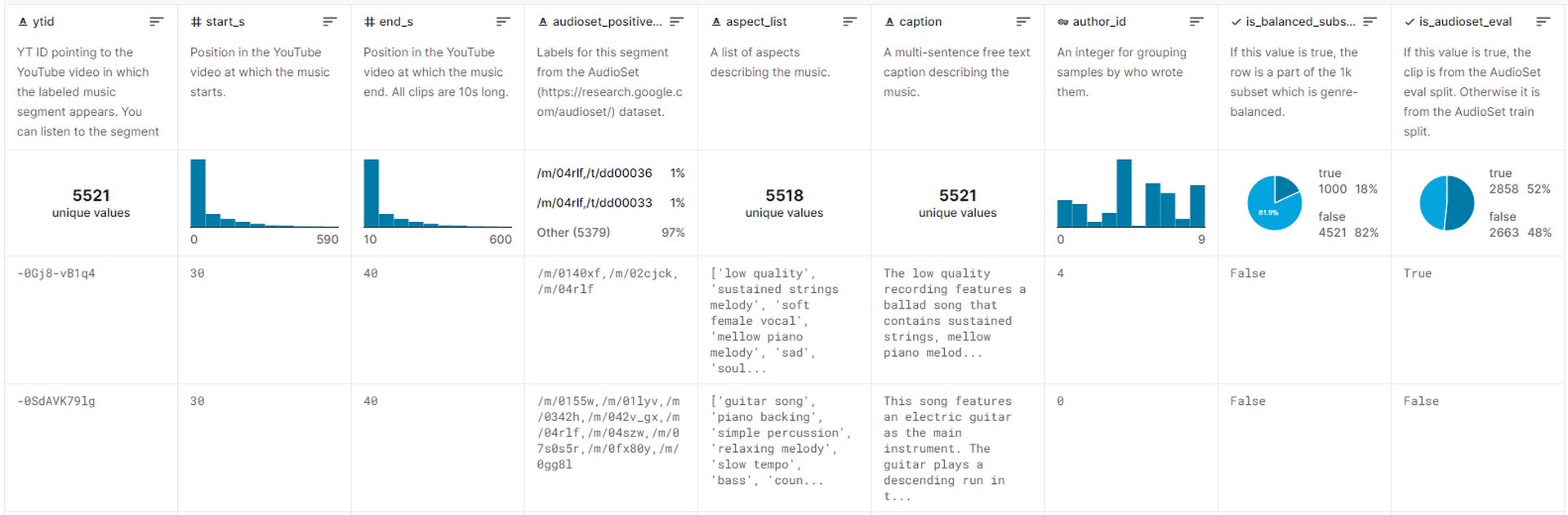

Набор данных, используемый для обучения MusicLM, содержит примерно 5,5 тыс. пар музыка-текст. Этот набор данных включает более 200 000 часов музыкисопровождаемый расширенные текстовые описания предоставляется экспертами-людьми. Google выпустил этот набор данных на Kaggle под названием MusicCaps.и в настоящее время к нему может получить доступ публика.

Создание музыки с помощью MusicLM

К сожалению, В настоящее время Google не планирует распространять модели, связанные с MusicLM., ссылаясь на необходимость дополнительной работы. Тем не менее, официальный документ, выпущенный Google, содержит множество примеров, демонстрирующих, как можно создавать музыку с помощью текстовых описаний.

Вот несколько подходов к созданию музыки с помощью MusicLM:

- Богатые подписи: Предоставляя подробные описания например «Основной саундтрек аркадной игры. Он динамичный и оптимистичный, с запоминающимся риффом электрогитары. Музыка повторяется и легко запоминается, но с неожиданными звуками, такими как грохот тарелок или барабанная дробь», MusicLM может создавать музыку, которая соответствует определенному контексту и требованиям.

- Долгое поколение: Этот подход включает в себя создание непрерывного и высококачественного звука в течение длительных периодов времени, например 5 минут. Используя такие подсказки, как «Хэви-метал» или «Успокаивающее регги», пользователи могут получить музыку в нужном жанре и стиле.

- Режим истории: Примечательной особенностью MusicLM является возможность генерировать музыкальную последовательность на основе серии текстовых подсказок. Например, указав разные промежутки времени и соответствующие мероприятия, такие как «время для медитации (0:00-0:15)“, “время просыпаться (0:15-0:30)“ и так далее, пользователи могут организовать музыкальное путешествие.

- Оформление текста и мелодии: Этот подход позволяет пользователям создавать музыку, соответствующую заданной мелодии, например гудящая или свистящая последовательность при соблюдении данной текстовой подсказки. По сути, он преобразует одну звуковую последовательность в желаемый результат.

- Оформление подписи к картине: MusicLM может генерировать музыку на основе описаний картин. Например, предоставив описание знаменитого произведения Сальвадора Дали «Постоянство памяти“, модель может создавать музыку, вдохновленную концепциями и образами картины.

- Места: Описания конкретных мест или окружения могут служить подсказками для создания музыки. Например, используя такое описание, как «солнечное и спокойное время на пляже“, MusicLM может генерировать музыку, отражающую суть этой настройки.

Дополнительные примеры включают генерацию звука из текста за 10 секунд с учетом уровня опыта музыканта, эпохи и даже соло на аккордеоне. MusicLM предлагает универсальный набор возможностей для создания музыки в различных областях и сценариях.

Впечатляющие возможности MusicLM в создании музыка высокого качества продемонстрировать замечательный потенциал человеческого творчества, а не полагаться исключительно на алгоритмы ИИ. Однако это продвижение также повышает этические проблемы и может столкнуться с сопротивлением музыкального сообществапохожие на модели генерации изображений, такие как Dalle и ChatGPT.

Исследователи Google признают этические вопросы связанные с такой системой, как MusicLM, включая возможность включение защищенного авторским правом контента из обучающих данных в сгенерированные песни. В ходе экспериментов они обнаружили, что 1% музыки, сгенерированной системой, напрямую копировала песни из своих обучающих данных. Этот процент считался слишком высоко выпустить MusicLM в его нынешнем виде.

Хотя маловероятно, что MusicLM станет общедоступным приложением в ближайшем будущем, мы можем ожидать появления музыкальных моделей с открытым исходным кодом, которые могут быть перепроектированы независимыми разработчиками. Будущее захватывающие возможности за использование языковых моделей для повышения музыкального творчества и самовыражения, обеспечивая при этом ответственное и этичное использование этих технологий.

Source: Как использовать Google MusicLM: подробное руководство