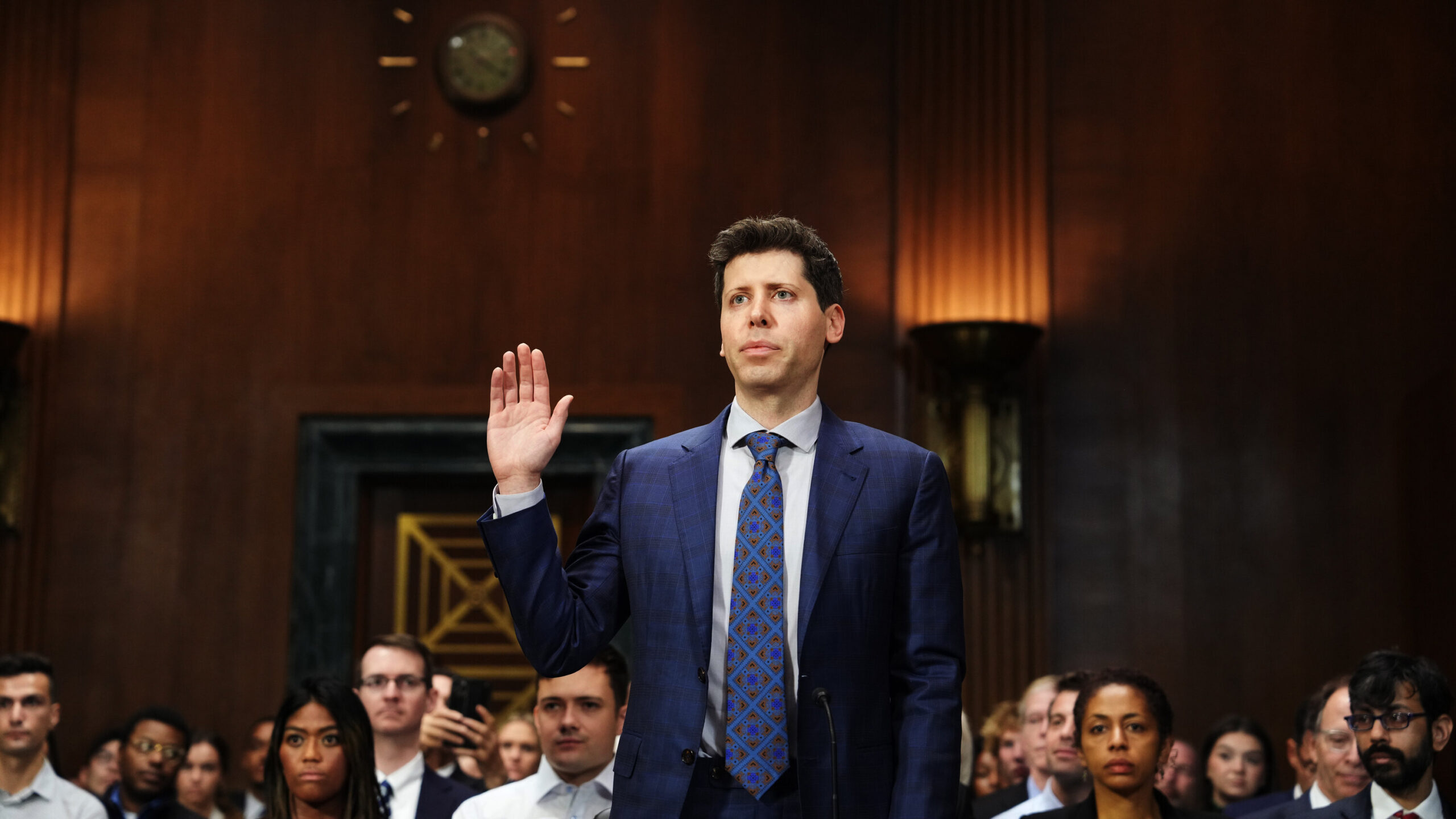

Генеральный директор OpenAI Сэм Альтман продолжает свою международную деятельность, опираясь на импульс, созданный его недавними выступлениями перед Конгрессом США. Однако подход Альтмана за границей отличается от климата, благоприятного для ИИ в Соединенных Штатах, поскольку он намекает на возможность перемещения своих технологических предприятий, если не будут соблюдаться его правила.

Кругосветное путешествие Альтмана привело его из Лагос, Нигерия в различные европейские направления, кульминацией которых является Лондон, Великобритания. Несмотря на некоторые протесты, он активно взаимодействует с видными деятелями технологической индустрии, бизнеса и политиков, подчеркивая возможности языковой модели OpenAI ChatGPT. Альтман стремится заручиться поддержкой правил, поддерживающих ИИ, одновременно выражая недовольство определением Европейского Союза систем «высокого риска», как это обсуждалось на панели в Университетском колледже Лондона.

Предлагаемый Европейским союзом закон об искусственном интеллекте вводит трехуровневую классификацию систем ИИ на основе уровней риска. К примерам ИИ, представляющим «неприемлемый риск» в связи с нарушением основных прав, относятся системы социальной оценки и манипулятивная социальная инженерия ИИ. С другой стороны, «системы искусственного интеллекта с высоким риском» должны соответствовать всеобъемлющим стандартам прозрачности и надзора с учетом их предполагаемого использования.

Сэм Альтман выразил обеспокоенность по поводу текущего проекта закона, заявив, что и ChatGPT, и предстоящий GPT-4 потенциально могут попасть в категорию высокого риска. В таких случаях необходимо соблюдение конкретных требований. Альтман подчеркнул намерение OpenAI стремиться к соответствию, но признал, что существуют технические ограничения, которые могут повлиять на их способность сделать это. Как сообщает Время, заявил он: «Если мы сможем выполнить требования, мы это сделаем, а если не сможем, мы прекратим работу… Мы постараемся. Но есть технические ограничения на то, что возможно».

Закон ЕС об искусственном интеллекте обновляется по мере улучшения искусственного интеллекта

Первоначально направленный на решение проблем, связанных с китайской системой социального кредита и распознаванием лиц, Закон об ИИ столкнулся с новыми проблемами с появлением OpenAI и других стартапов. Впоследствии в декабре ЕС представил положения, нацеленные на «основополагающие модели», такие как большие языковые модели (LLM), на которых работают чат-боты с искусственным интеллектом, такие как ЧатGPT. Недавно комитет Европейского парламента утвердил эти обновленные правила, обеспечивающие проверку безопасности и управление рисками.

В отличие от Соединенных Штатов, ЕС продемонстрировал большую склонность к тщательному изучению OpenAI. Европейский совет по защите данных активно следит за соблюдением ChatGPT законов о конфиденциальности. Однако важно отметить, что Закон об ИИ все еще может быть пересмотрен, что, вероятно, объясняет глобальное турне Альтмана, стремящегося ориентироваться в меняющемся ландшафте правил ИИ.

Альтман повторил знакомые моменты из своего недавнего выступления в Конгрессе, выразив как озабоченность по поводу рисков ИИ, так и признание его потенциальных преимуществ. Он выступал за регулирование, включая требования безопасности и регулирующее агентство для проверки соответствия. Альтман призвал к регуляторному подходу, обеспечивающему баланс между европейскими и американскими традициями.

Однако Альтман предостерег от правил, которые могут ограничить доступ пользователей, нанести ущерб небольшим компаниям или воспрепятствовать движению ИИ с открытым исходным кодом. Меняющаяся позиция OpenAI в отношении открытости, ссылаясь на конкуренцию, контрастирует с его предыдущей практикой. Стоит отметить, что любые новые правила по своей сути принесут пользу OpenAI, предоставляя основу для подотчетности. Проверки соответствия также могут увеличить стоимость разработки новых моделей ИИ, что даст компании преимущество в конкурентной среде ИИ.

Несколько стран наложили запреты на ChatGPT, и Италия является одной из них. Однако после того, как OpenAI усилил контроль конфиденциальности пользователей, крайне правое правительство Италии сняло запрет. OpenAI, возможно, придется продолжать решать проблемы и идти на уступки, чтобы поддерживать благоприятные отношения с правительствами по всему миру, особенно с учетом его большой пользовательской базы, насчитывающей более 100 миллионов активных пользователей ChatGPT.

Почему правительства осторожно относятся к чат-ботам с искусственным интеллектом?

Существует ряд причин, по которым правительства могут налагать запреты на ChatGPT или аналогичные модели ИИ по нескольким причинам:

- Дезинформация и фейковые новости: модели ИИ, такие как ChatGPT, могут генерировать вводящую в заблуждение или ложную информацию, способствуя распространению дезинформации. Правительства могут налагать запреты для предотвращения распространения неточного или вредоносного контента.

- Неприемлемый или оскорбительный контент: модели ИИ могут генерировать неуместный, оскорбительный или нарушающий культурные нормы и ценности контент. Правительства могут запретить ChatGPT, чтобы защитить граждан от нежелательных материалов.

- Этические проблемы: модели ИИ поднимают этические вопросы, связанные с конфиденциальностью, согласием и предвзятостью. Правительства могут налагать запреты для решения проблем, связанных с конфиденциальностью данных, потенциальным неправомерным использованием личной информации или сохранением предвзятости в контенте, созданном ИИ.

- Соответствие нормативным требованиям: модели ИИ должны соответствовать существующим законам и правилам. Правительства могут наложить запреты, если обнаружат, что ChatGPT не соответствует нормативным требованиям, таким как защита данных или стандарты контента.

- Национальная безопасность и социальная стабильность: правительства могут воспринимать модели ИИ как потенциальную угрозу национальной безопасности или социальной стабильности. Они могут налагать запреты, чтобы предотвратить неправомерное использование технологии ИИ в злонамеренных целях или для сохранения контроля над потоком информации.

Стоит отметить, что конкретные причины наложенных правительством запретов на ChatGPT могут различаться в зависимости от юрисдикции, и на решения влияет сочетание правовые, этические, социальные и политические факторы. Чтобы узнать о некоторых текущих рисках и нежелательных последствиях чат-ботов с искусственным интеллектом, ознакомьтесь с этими последними статьями:

- Выявленные риски ChatGPT: понимание потенциальных угроз

- Темная сторона ChatGPT: человеческая цена успеха ИИ

Source: Сэм Альтман из OpenAI угрожает выходом из ЕС на фоне переговоров о регулировании ИИ