Хотя языковое моделирование занимает все больше и больше места в технологиях искусственного интеллекта, мы считаем своим долгом объяснить нашим уважаемым читателям, что такое искусственный интеллект шиншилл и как его использовать.

Исследователи из DeepMind создали модель Chinchilla, которая имеет 70 миллиардов параметров и в четыре раза больше данных, чем Gopher, но с таким же вычислительным бюджетом. Производительность Chinchilla примечательна не только размером улучшения, но и тем, что она меньше, чем любые другие основные языковые модели, созданные за предыдущие два года, которые продемонстрировали производительность SOTA.

Chinchilla постоянно и значительно превосходит Gopher (280B), GPT-3 (175B), Jurassic-1 (178B) и Megatron-Turing NLG в различных последующих задачах оценки (530B). Он использует значительно меньше вычислений для логического вывода и точной настройки, что значительно увеличивает использование последующих потоков. Вам интересно, что такое Шиншилла ИИ? Давайте исследуем это в этой статье.

Что такое Шиншилла ИИ?

Давайте начнем с понимания того, что такое ИИ шиншиллы, прежде чем научиться использовать ИИ шиншиллы. Недавние проблемы языкового моделирования, как правило, увеличивают сложность модели без увеличения количества обучающих токенов (около 300 миллиардов за время обучения). Самой большой моделью трансформера на данный момент является Megatron-Turing NLG, которая более чем в три раза больше, чем GPT-3 OpenAI. DeepMind представила совершенно новую языковую модель под названием Chinchilla.

Есть одно существенное отличие, несмотря на то, что он работает аналогично большим языковым моделям, таким как Megatron-Turing NLG (параметры 530B), Jurassic-1 (параметры 178B), GPT-3 (параметры 175B), Gopher (параметры 280B) и GPT- 3: Имея всего 70 миллиардов параметров и в четыре раза больше данных, чем Gopher, он достигает средней точности 67,5 % в тесте MMLU, что на 7 % больше, чем у Gopher.

Как использовать ИИ шиншилл?

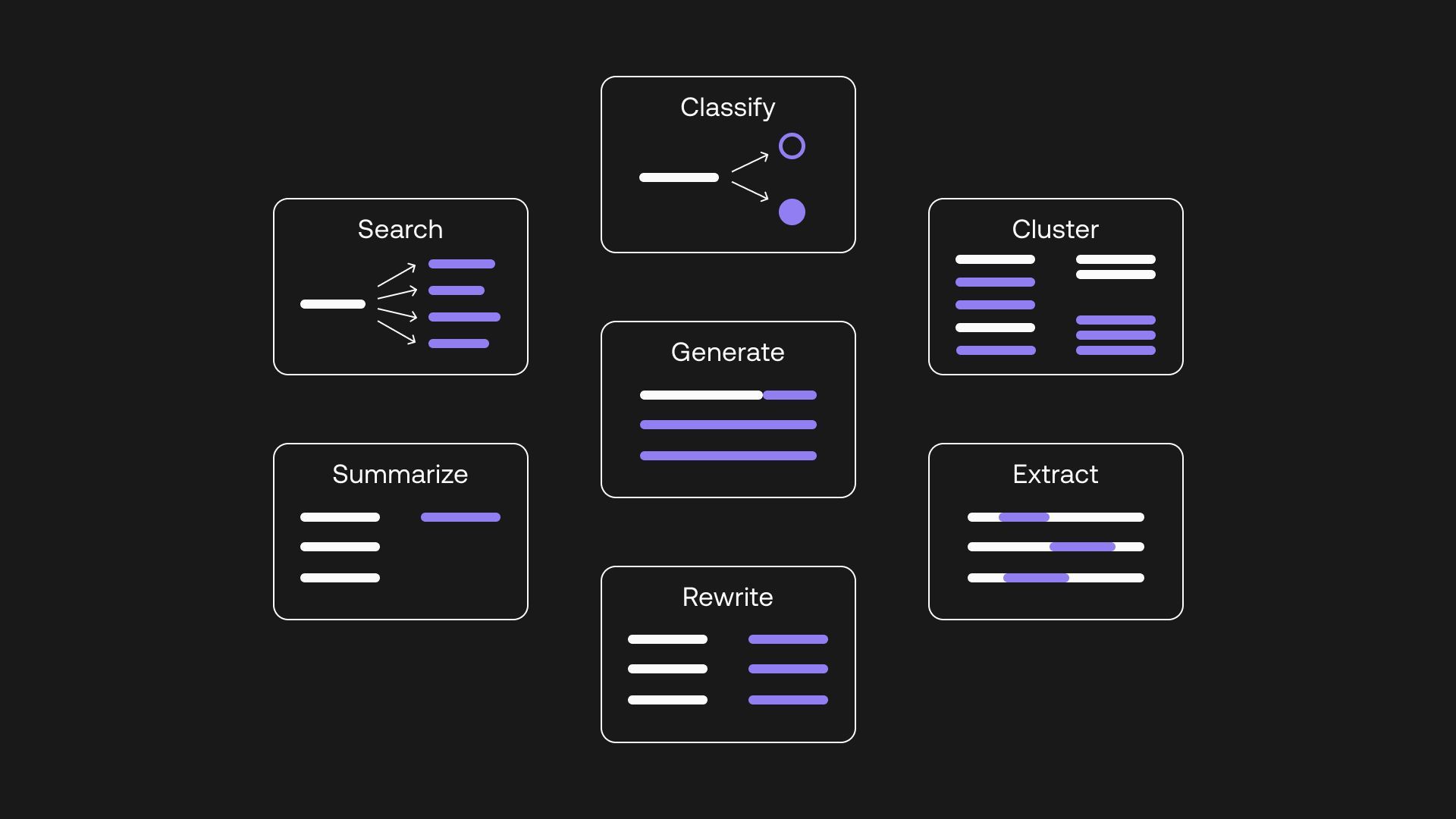

Теперь, когда мы объяснили вам, что такое ИИ шиншиллы, давайте перейдем к ответам на ваши вопросы, как использовать ИИ шиншиллы, но у нас есть для вас плохие новости. К сожалению, в настоящее время широкая публика не может получить к нему доступ. ИИ Chinchilla в конечном итоге станет доступен в ближайшие месяцы, после чего вы сможете использовать его для разработки чат-ботов, виртуальных помощников, прогностических моделей и других приложений ИИ.

Chinchilla достигла передовой средней точности 67,5% в тесте MMLU, опередив Gopher на 7%. Обычная стратегия обучения модели большого языка заключалась в построении модели без увеличения запаса обучающих токенов. Самый большой плотный трансформатор, MT-NLG 530B, теперь более чем в три раза больше, чем 170 миллиардов характеристик GPT-3.

ИИ Chinchilla станет доминирующей силой в языковом моделировании

Теперь, когда мы ответили на ваш вопрос, что такое ИИ шиншилл и как его использовать, давайте поговорим о технологиях ИИ в целом.

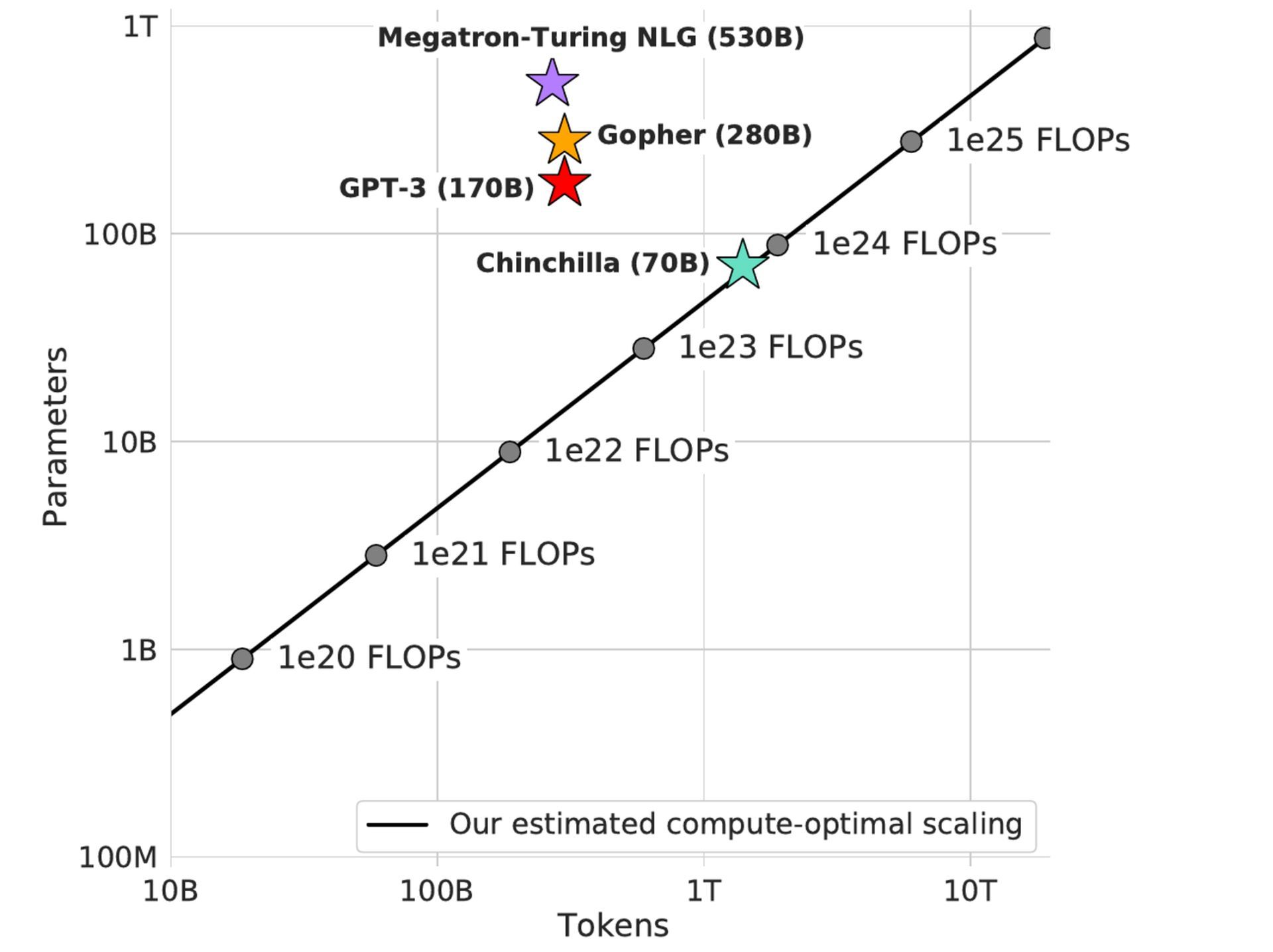

Расширение модели без увеличения количества обучающих токенов было распространенным подходом в обучении больших языковых моделей. По сравнению со 170 миллиардами характеристик GPT-3, самый большой плотный трансформатор MT-NLG 530B теперь более чем в 3 раза больше.

Большинство крупных моделей, используемых в настоящее время, включая Chinchilla от DeepMind, были обучены более чем 300 миллиардам токенов. Гонка за обучением все более и более крупных моделей приводит к созданию моделей, которые, по мнению исследователей, значительно отстают по сравнению с тем, что можно было бы сделать с тем же бюджетом вычислений. Это верно даже при том, что желание тренировать эти мегамодели значительно продвинуло инженерию.

Функции искусственного интеллекта Chinchilla, которые преодолеют вычислительный бюджет

Ограничивающим фактором в технологиях ИИ обычно является бюджет вычислений, который независим и известен заранее. Сумма денег, которую корпорация может потратить на лучшее оборудование, в конечном итоге определит размер модели и количество обучающих токенов. Чтобы решить эту проблему, функции ИИ шиншиллы:

- Фиксированный размер модели: Программисты DeepMind создали семейство фиксированных размеров моделей (70M-16B) и скорректировали количество обучающих токенов для каждой модели (4 варианта). Затем была определена наилучшая комбинация для каждого вычислительного бюджета. Согласно этому методу, модель, обученная с той же вычислительной мощностью, что и у Gopher, будет иметь 1,5 трлн токенов и 67 млрд параметров.

- Кривые для isoFLOP: инженеры DeepMind экспериментировали с размером модели и фиксированным бюджетом вычислений. Результатом этого метода будет оптимальная для вычислений модель с 63 миллиардами параметров и 1,4 триллиона токенов, обученная с тем же объемом вычислений, что и Gopher.

- Создание параметрической функции потерь: инженеры DeepMind смоделировали потери как параметрические функции размера модели и количества токенов, используя результаты методов 1 и 2. Модель, оптимальная для вычислений, обученная с использованием этого метода, будет иметь 40 миллиардов параметров и такой же объем вычислений, как Gopher.

Если вам интересно, вы можете изучить подход DeepMind к предмету из опубликованной ими статьи.

Мы подходим к концу нашей статьи, в которой мы ответили на вопросы о том, что такое ИИ шиншиллы и как его использовать наилучшим образом для вас. Хотя технологии языкового моделирования сумели стать самой заметной подкатегорией ИИ в 2022 году, нам интересно, что нас ждет в 2023 году.

Source: Что такое шиншилловый ИИ и как его использовать?