Microsoft имеет выкатил новая захватывающая разработка в области языковых моделей: 1-битный LLM. Это продвижение, вдохновленный исследовательскими проектами, такими как BitNet, знаменует собой заметный сдвиг в способах построения и оптимизации языковых моделей. В основе этого нововведения лежит поразительно эффективный метод представления параметров модели (или весов).используя всего 1,58 бита, в отличие от традиционных 16-битных чисел с плавающей запятой (FP16). подход, распространенный в более ранних моделях.

Первый в своем роде 1-битный LLM

Дублированный БитНет LLM b1.58этот новаторский подход ограничивает потенциальные значения каждого веса всего тремя вариантами: -1, 0 или +1. Такое резкое сокращение количества битов, необходимых для каждого параметра, является основой этой революционной технологии. Удивительно, но, несмотря на небольшое потребление битов, BitNet b1.58 умудряется обеспечивают показатели производительности, сопоставимые с показателями традиционных моделей. Сюда входят такие области, как недоумение и производительность конечной задачи, при этом используются одинаковые наборы обучающих данных того же размера.

Что такое 1-битные LLM?

Сфера генеративного искусственного интеллекта развивается день ото дня., и последним прорывом в этой динамичной области стало появление 1-битных моделей изучения языка. Это может показаться удивительным, но эта разработка может изменить сферу искусственного интеллекта, устранив некоторые из наиболее серьезных препятствий, с которыми сегодня сталкиваются LLM:а именно, их гигантские размеры.

Обычно веса модели машинного обучения, будь то LLM или что-то столь же простое, как логистическая регрессия, хранятся с использованием либо 32-битные или 16-битные числа с плавающей запятой. Этот стандартный подход – палка о двух концах; хотя это обеспечивает высокую точность расчетов модели, это также приводит к огромному размеру этих моделей.

Именно из-за этого раздувания развертывание таких чемпионов-тяжеловесов, как GPT, в локальных системах или в производственных средах становится логистическим кошмаром. Астрономическое количество весов, обусловленное точностью этих плавающих точек, увеличивает их размер до неуправляемых размеров.

В отличие от традиционных моделей, 1-битные LLM используют только один бит — 0 или 1 — для представления весовых параметров. Эта, казалось бы, незначительная настройка имеет серьезные последствия: она резко сокращает общий размер моделей, возможно, с огромным отрывом.

Такое сокращение размеров открывает путь к развертыванию LLM на гораздо меньших устройствахделая передовые приложения искусственного интеллекта более доступны и осуществимы на более широком спектре платформ.

Вернуться к BitNet LLM b1.58

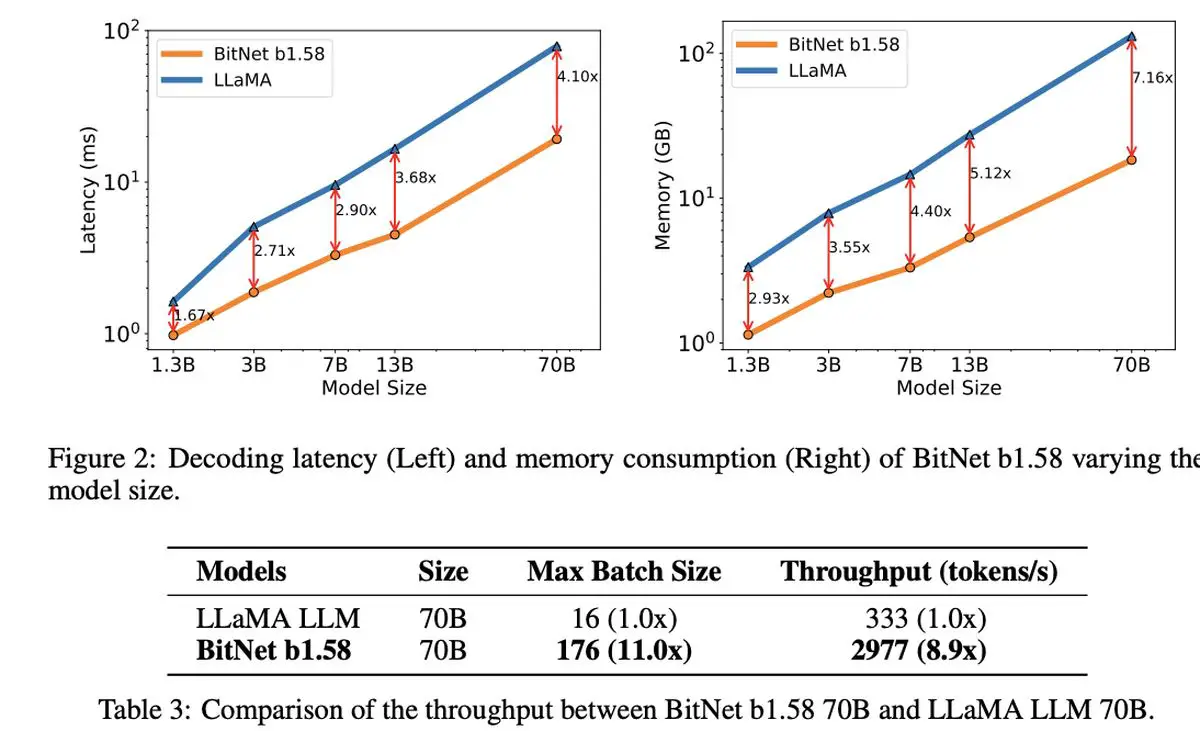

Что действительно примечательно в 1,58-битном LLM, так это его экономическая эффективность. Модель отличается уменьшенной задержкой, меньшим использованием памяти, повышенной пропускной способностью и снижением энергопотребления, представляя собой устойчивый вариант в вычислительно интенсивном мире искусственного интеллекта.

1-битный LLM от Microsoft отличается не только своей эффективностью. Он представляет собой свежий взгляд на масштабирование и обучение языковых моделей, сочетая первоклассную производительность с экономической целесообразностью. Это намекает на зарождение новых вычислительных парадигм и возможность создания специализированного оборудования, предназначенного для запуска этих более простых и эффективных моделей.

Также открывается дискуссия вокруг BitNet LLM b1.58. интригующие возможности более эффективного управления длинными последовательностями в LLMпредлагая потенциальные области для дальнейших исследований в методах сжатия без потерь, чтобы еще больше повысить эффективность.

В тени этого примечательного нововведения Microsoft также произвела фурор своей последней моделью небольшого языка Phi-2. Этот мощный центр с 2,7 миллиардами параметров продемонстрировал исключительные способности к пониманию и рассуждению, что является еще одним свидетельством постоянного стремления Microsoft расширять границы технологий искусственного интеллекта. Внедрение 1-битного LLM, наряду с успехом Phi-2, ознаменует захватывающую эпоху инноваций и эффективности в разработке языковых моделей.

Предоставленное изображение предоставлено: Дрю Бимер/Unsplash

Source: Microsoft представляет свой 1-битный LLM