Nvidia совершает революцию в мире вычислений с искусственным интеллектом с помощью недавний запуск NVIDIA H200. Эта передовая платформа, построенная на NVIDIA Хоппер архитектуре, может похвастаться мощным графическим процессором NVIDIA H200 Tensor Core, оснащенным расширенная память предназначен для решения значительные нагрузки данных для рабочих нагрузок генеративного искусственного интеллекта и высокопроизводительных вычислений (HPC).

архитектуре, может похвастаться мощным графическим процессором NVIDIA H200 Tensor Core, оснащенным расширенная память предназначен для решения значительные нагрузки данных для рабочих нагрузок генеративного искусственного интеллекта и высокопроизводительных вычислений (HPC).

В этой статье мы углубимся в недавний запуск и предоставим как можно больше подробностей о новом NVIDIA H200.

Мощь NVIDIA H200

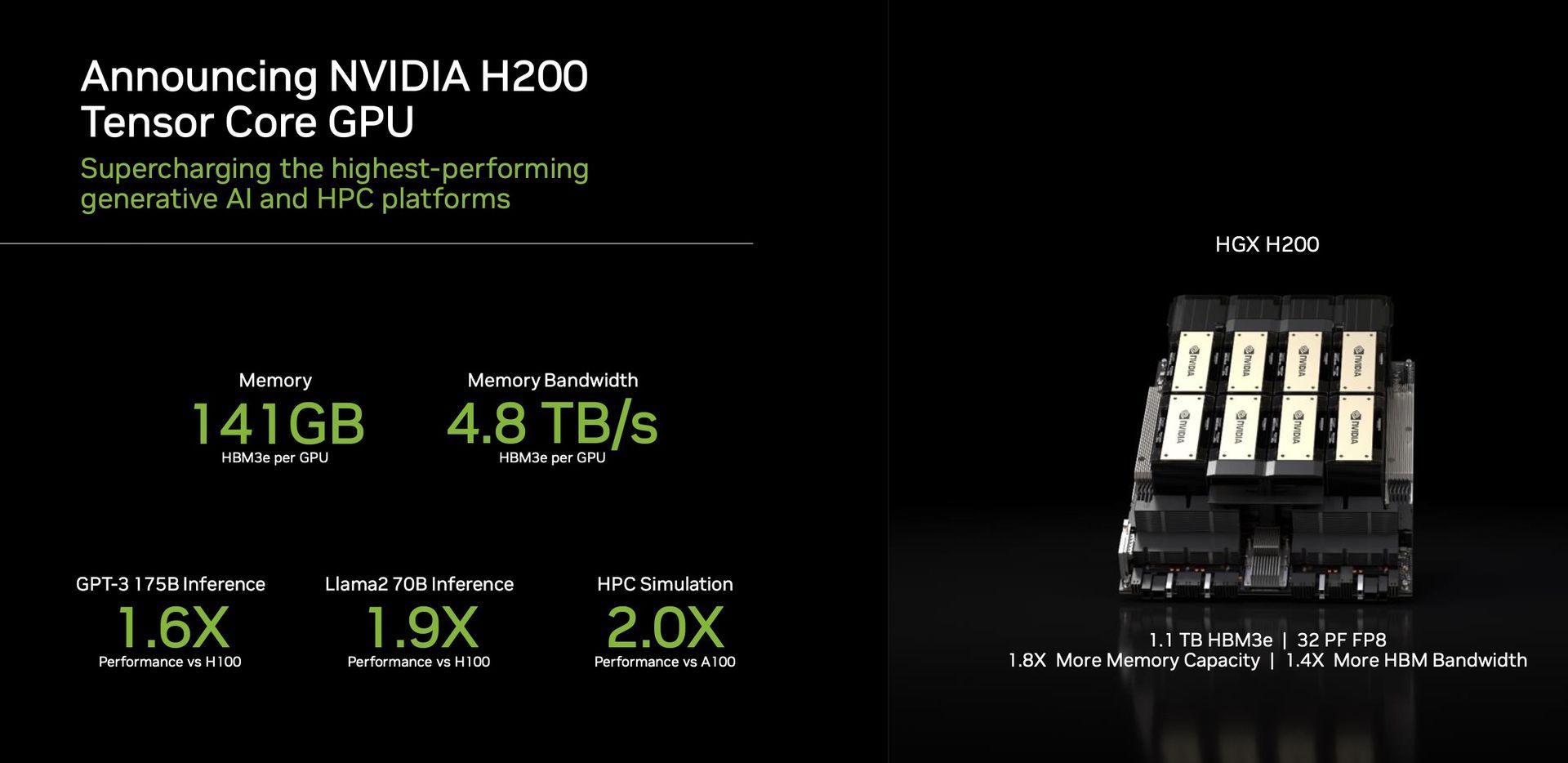

Отличительной особенностью H200 является использование HBM3e, первый графический процессор, предлагающий более быструю и большую память. Это достижение способствует ускорению генеративного искусственного интеллекта и больших языковых моделей, одновременно расширяя границы научные вычисления для рабочих нагрузок HPC. Благодаря HBM3e H200 обеспечивает впечатляющие 141 ГБ памяти с ошеломляющим эффектом 4,8 терабайта в секунду. Это почти вдвое увеличивает емкость и Пропускная способность в 2,4 раза выше по сравнению со своим предшественником, NVIDIA A100.

Производительность и приложения

H200 на базе NVIDIA НВЛинк и НВСвитч

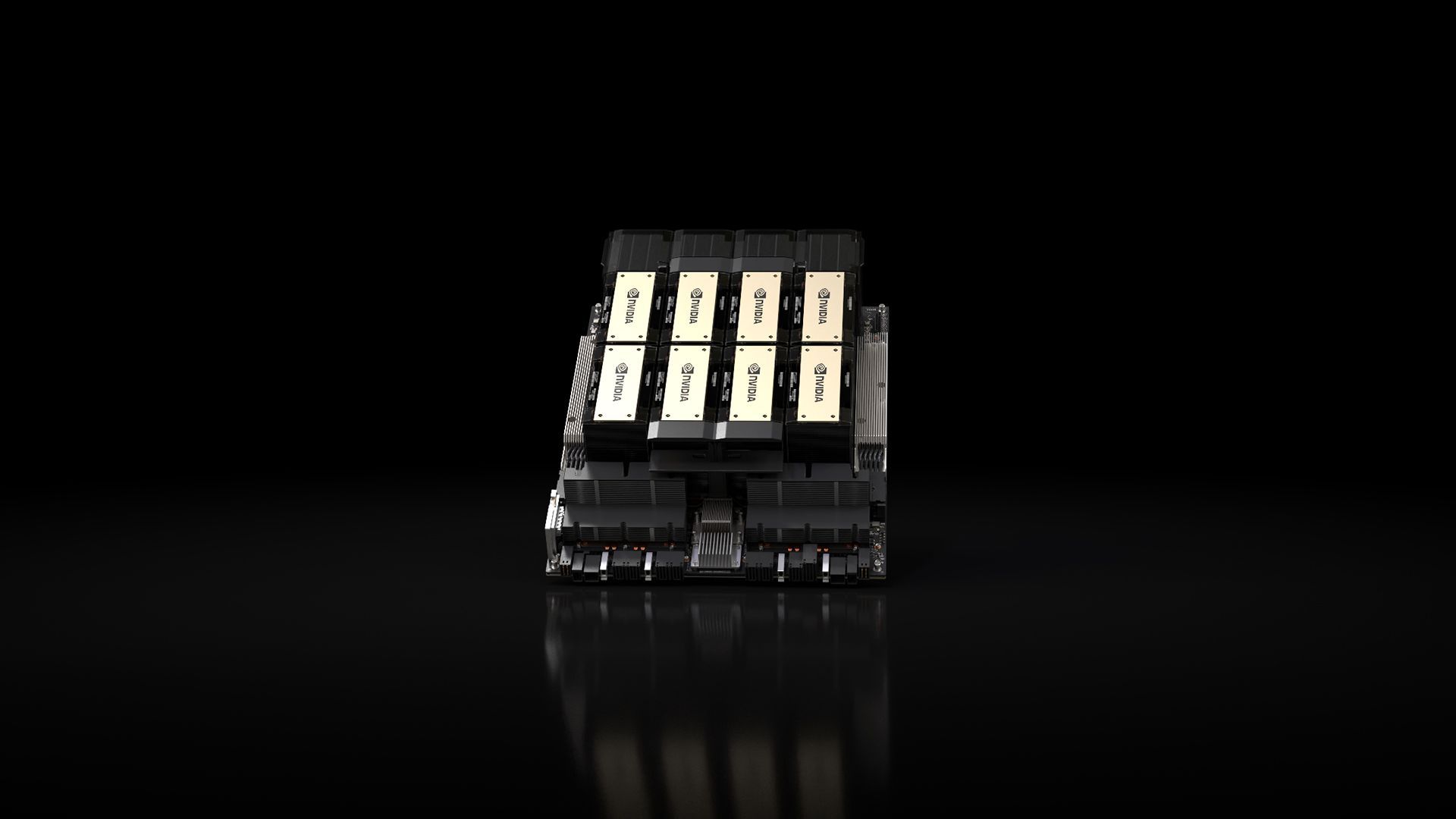

и НВСвитч высокоскоростные межсоединения, обещания непревзойденная производительность при различных рабочих нагрузках приложений. Это включает в себя его мастерство в обучении LLM (большая языковая модель) и вывод моделей, превосходящих колоссальные 175 миллиардов параметров. Восьмиполосный HGX H200 выделяется тем, что обеспечивает более 32 петафлопс глубины FP8 обучение вычислениям и совокупная высокоскоростная память объемом 1,1 ТБ, обеспечение максимальной производительности в генеративных приложениях искусственного интеллекта и высокопроизводительных вычислений.

высокоскоростные межсоединения, обещания непревзойденная производительность при различных рабочих нагрузках приложений. Это включает в себя его мастерство в обучении LLM (большая языковая модель) и вывод моделей, превосходящих колоссальные 175 миллиардов параметров. Восьмиполосный HGX H200 выделяется тем, что обеспечивает более 32 петафлопс глубины FP8 обучение вычислениям и совокупная высокоскоростная память объемом 1,1 ТБ, обеспечение максимальной производительности в генеративных приложениях искусственного интеллекта и высокопроизводительных вычислений.

Графические процессоры Nvidia стали решающий в области генеративных моделей ИИ, играя решающую роль в их разработке и внедрении. Разработанные для обработки массивных параллельных вычислений, необходимых для обучения и запуска этих моделей, графические процессоры Nvidia превосходно справляются с такими задачами, как: генерация изображения и естественный язык обработка. Архитектура параллельной обработки позволяет этим графическим процессорам выполнять многочисленные вычисления одновременно, что приводит к существенному ускорению процессов генеративной модели ИИ.

H200 является свидетельством приверженности Nvidia постоянные инновации и скачки производительности. Опираясь на успех архитектуры Hopper, постоянные улучшения программного обеспечения, включая недавний выпуск библиотек с открытым исходным кодом, таких как NVIDIA ТензорРТ -магистр права, продолжать повышать производительность платформы. Внедрение NVIDIA H200 обещает дальнейший скачок: ожидается почти удвоение скорости вывода на таких моделях, как Llama 2, LLM с 70 миллиардами параметров, по сравнению с его предшественником H100.

-магистр права, продолжать повышать производительность платформы. Внедрение NVIDIA H200 обещает дальнейший скачок: ожидается почти удвоение скорости вывода на таких моделях, как Llama 2, LLM с 70 миллиардами параметров, по сравнению с его предшественником H100.

Универсальность и доступность

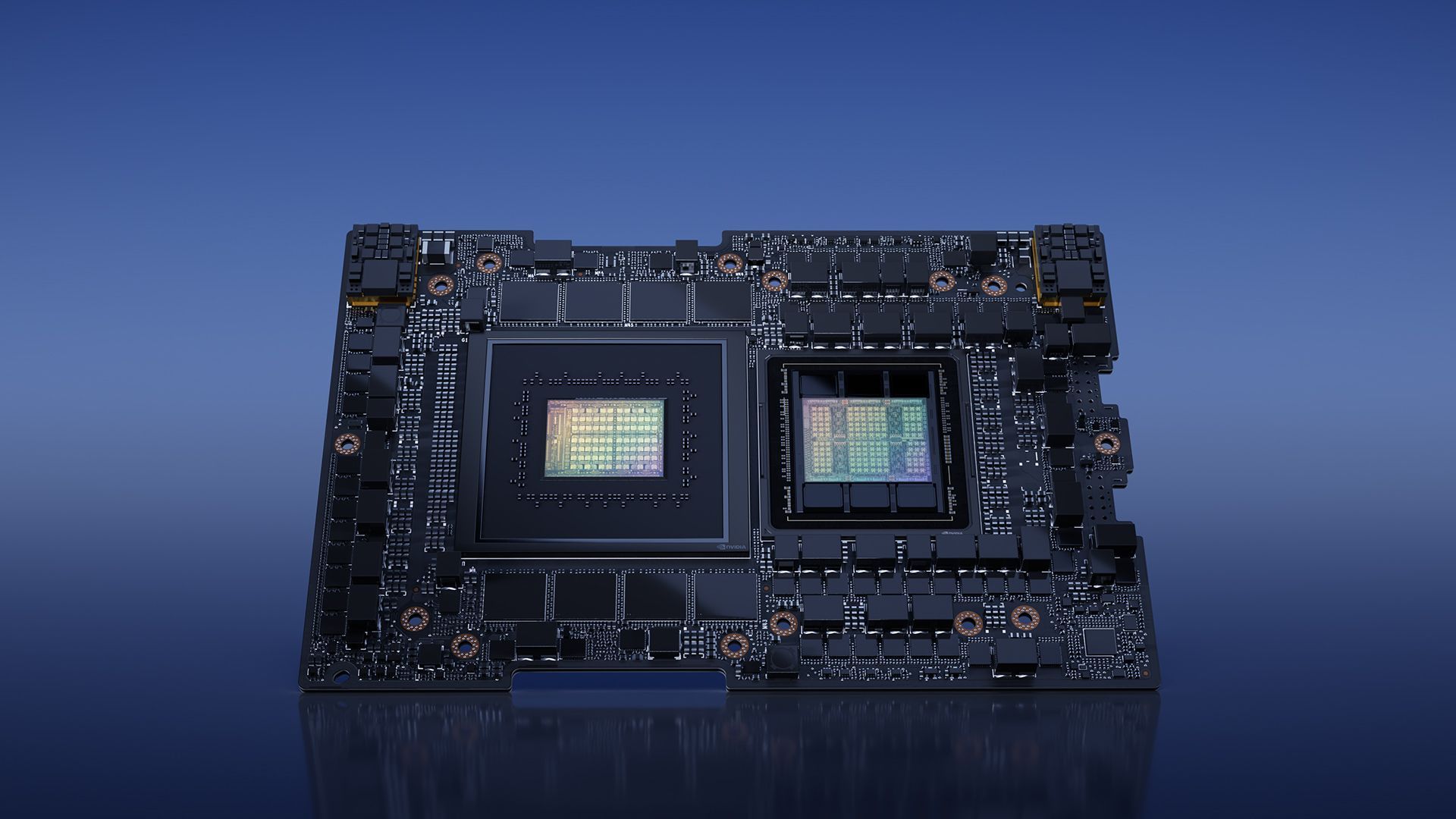

NVIDIA гарантирует универсальность с H200, предлагая его в различных форм-факторах, таких как серверные платы NVIDIA HGX H200 с четырех- и восьмипроцессорными конфигурациями. Эти конфигурации совместимы как с аппаратным, так и с программным обеспечением систем HGX H100. Кроме того, NVIDIA H200 доступна в NVIDIA GH200 Грейс Хоппер Суперчип с HBM3e, подходящий для различных конфигураций центров обработки данных, включая локальные, облачные, гибридные облачные и периферийные среды. Глобальная экосистема производителей серверов-партнеров может беспрепятственно обновлять существующие системы с H200, обеспечивая широкую доступность.

Суперчип с HBM3e, подходящий для различных конфигураций центров обработки данных, включая локальные, облачные, гибридные облачные и периферийные среды. Глобальная экосистема производителей серверов-партнеров может беспрепятственно обновлять существующие системы с H200, обеспечивая широкую доступность.

Энтузиасты и отраслевые эксперты с нетерпением ждут выпуска систем HGX H200, которые должны появиться на рынке в следующем году. второй квартал 2024 года. Выдающиеся мировые игроки, такие как Веб-сервисы Amazon, Гугл Облако, Microsoft Azure, и Облачная инфраструктура Oracle среди первая волна поставщиков облачных услуг готовы развернуть экземпляры на базе H200 в следующем году.

архитектура (Изображение предоставлено)

архитектура (Изображение предоставлено)В заключение отметим, что NVIDIA H200 с ее революционными функциями и возможностями производительности настроена на переопределить ландшафт вычислений с использованием искусственного интеллекта. По мере того, как H200 станет доступен во втором квартале 2024 года, он сможет расширить возможности разработчиков и предприятий по всему миру. ускорение разработки и внедрения приложений искусственного интеллекта от речи к гипермасштабному выводу.

Между тем, если вас интересует ведущая технологическая компания, обязательно ознакомьтесь с нашей статьей о том, как Nvidia и AMD работают над «чипом на базе рук».

Предоставленное изображение предоставлено: NVIDIA

Source: NVIDIA H200 представлен с большим нетерпением в сфере искусственного интеллекта