Знаете ли вы об истории технологий искусственного интеллекта, о которых постоянно говорят? Сегодня мы углубимся в тему: «Как долго существует ИИ?» вместе с тобой.

Искусственный интеллект (ИИ), относительно новая область с примерно 60-летней историей, представляет собой набор наук, теорий и методов, которые пытаются воспроизвести когнитивные способности человека. Это включает:

- Математическая логика

- Статистика, вероятность

- Вычислительная неврология

- Информатика

Начиная со Второй мировой войны, его достижения тесно связаны с достижениями в области вычислительной техники и позволяют компьютерам выполнять все более сложные задачи, которые ранее были пригодны исключительно для людей.

Как давно существует ИИ?

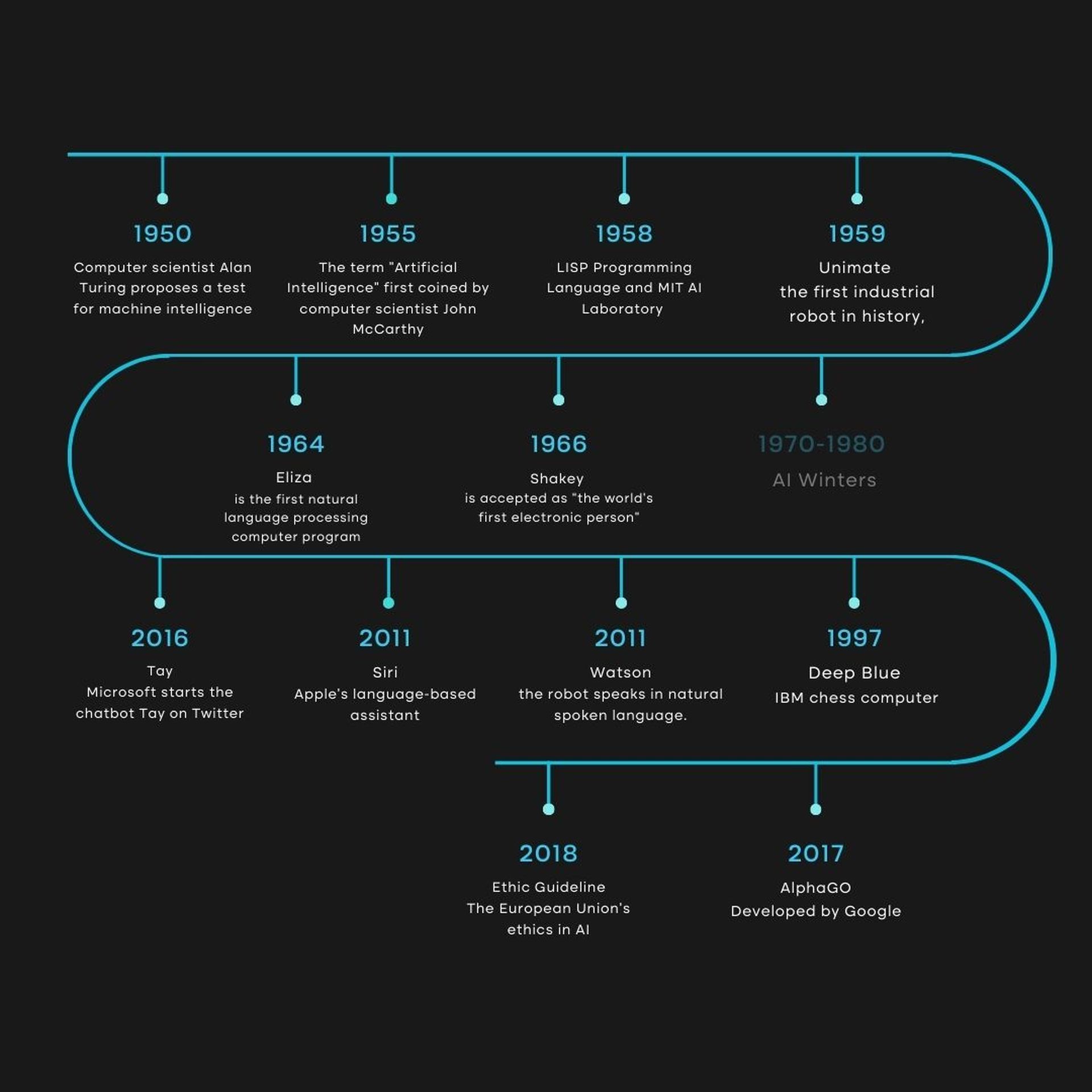

С 1940 года фраза об искусственном интеллекте (ИИ) присутствует в нашей жизни. Некоторые эксперты считают этот термин вводящим в заблуждение, поскольку эта технология все еще далека от истинного человеческого интеллекта. Их изучение еще не продвинулось до такой степени, чтобы его можно было сравнить с нынешними достижениями человечества. Достижения в фундаментальной науке необходимы для того, чтобы «сильный» ИИ, который пока только появился в научной фантастике, смог смоделировать весь мир.

Однако с 2010 года в этой области наблюдается новый всплеск популярности, в основном в результате значительного прогресса в вычислительной мощности компьютеров и легкого доступа к огромным объемам данных. Объективному пониманию вопроса мешают повторяющиеся обещания и беспокойства, о которых время от времени фантазируют.

По нашему мнению, краткий обзор истории дисциплины может послужить основой для нынешних дискуссий.

1940–1960: рождение ИИ.

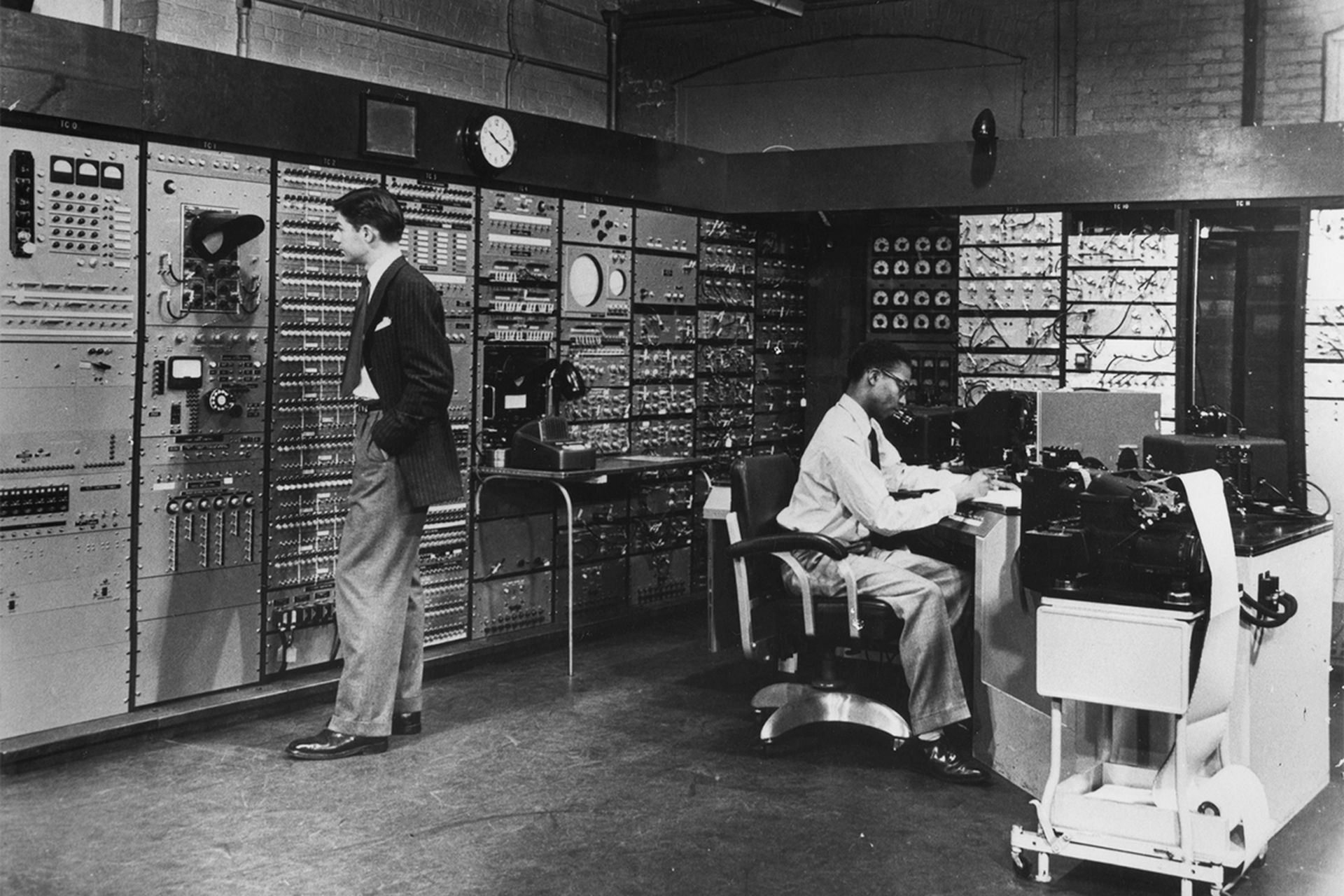

Слияние технологических достижений и стремление понять, как совместить функционирование машин и органических существ между 1940 и 1960 годами, произвело неизгладимое впечатление.

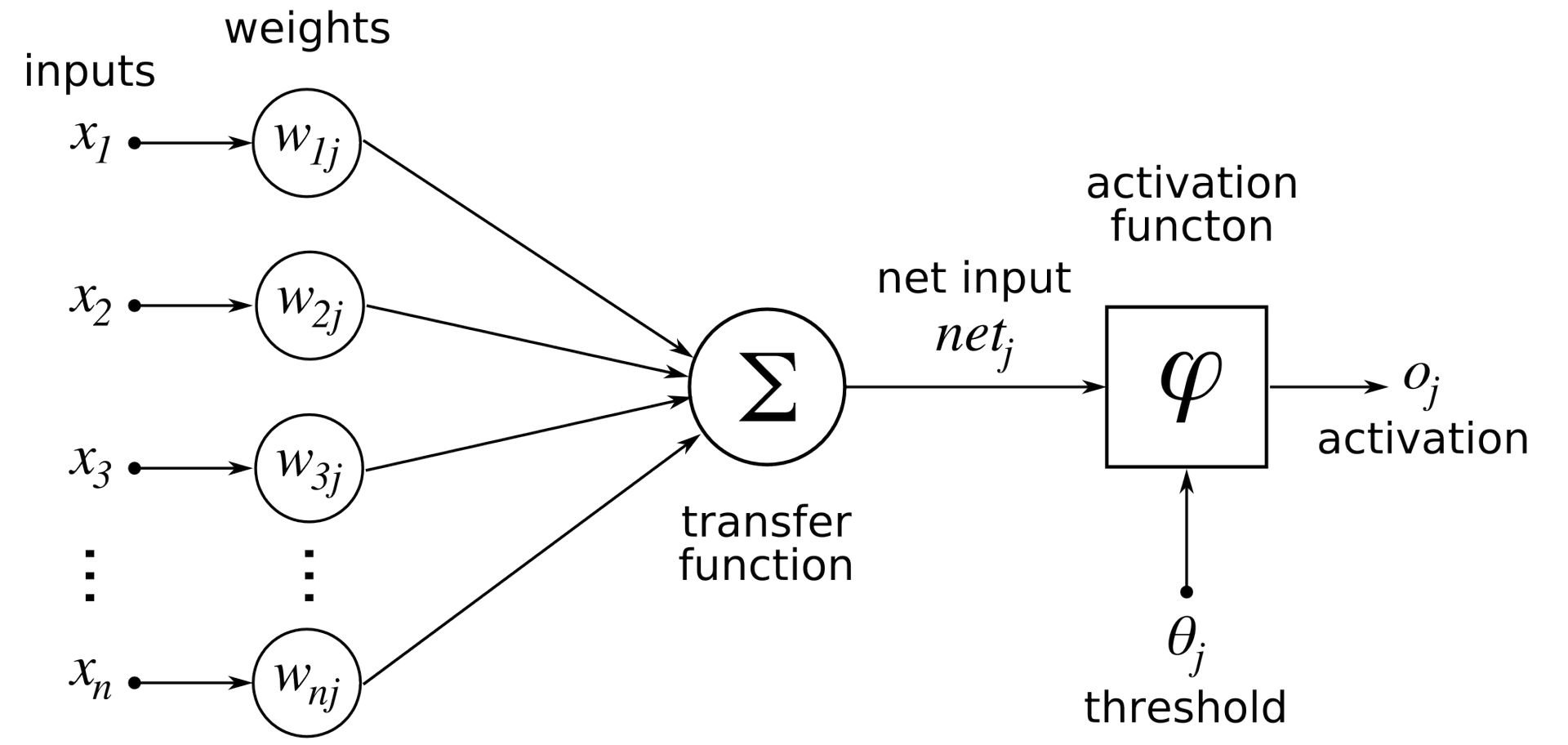

Для создания «целой теории управления и связи как у животных, так и у машин» Норберт Винер, пионер в области кибернетики, увидел необходимость объединить математическую теорию, электронику и автоматизацию. До этого Уоррен МакКаллох и Уолтер Питтс создали первую математическую и компьютерную модель биологического нейрона в 1943 году.

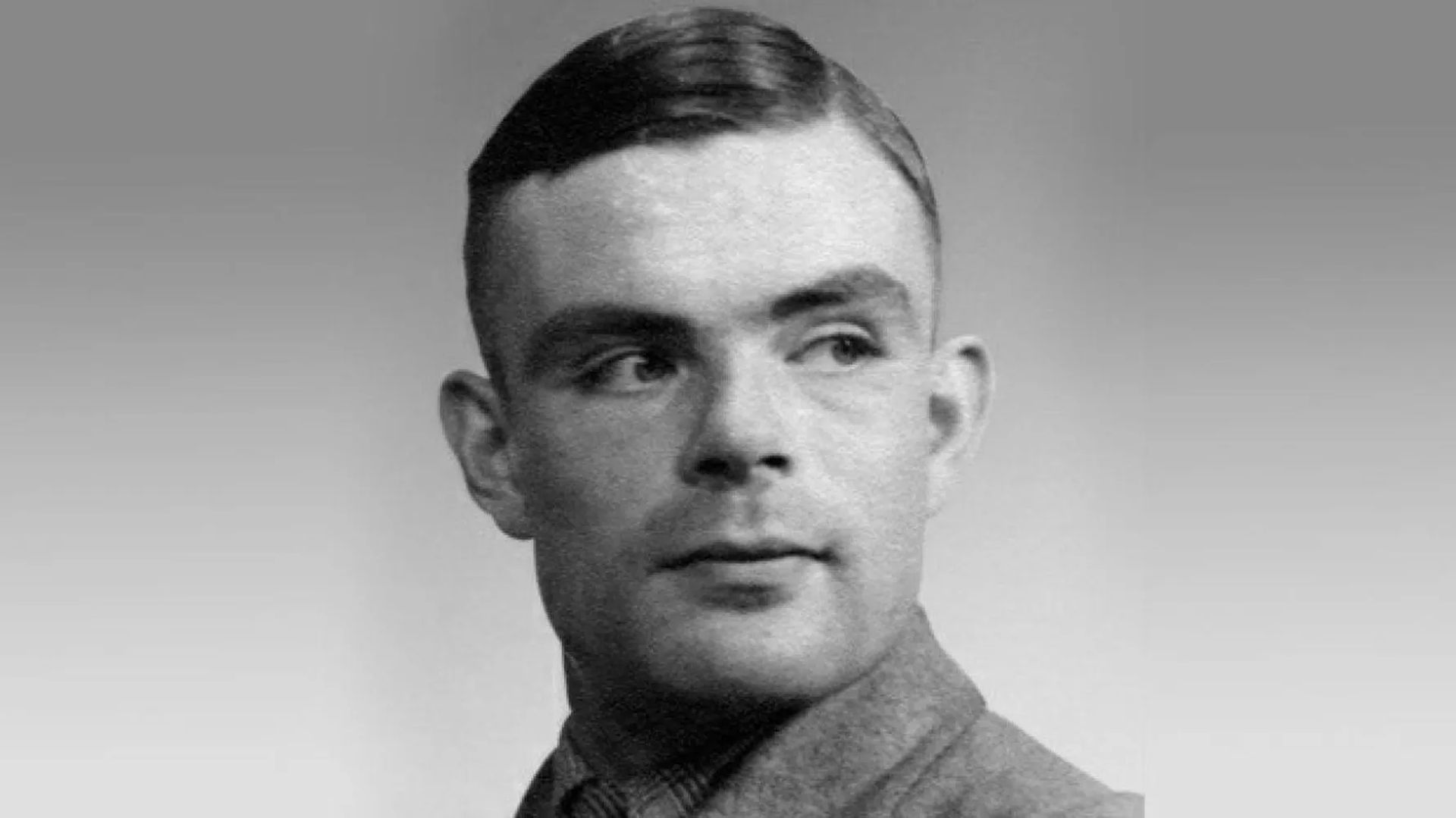

Хотя в начале 1950-х годов термин «искусственный интеллект» (ИИ) изобрели не они, Джон фон Нейман и Алан Тьюринг были пионерами лежащей в его основе технологии. Они помогли компьютерам перейти на десятичную логику XIX века, а машинам — на двоичную логику. Таким образом, два исследователя систематизировали архитектуру современных компьютеров и показали, что они представляют собой универсальное устройство, способное выполнять то, что запрограммировано. Тьюринг, с другой стороны, определил «игру в имитацию», в которой человек должен быть в состоянии сказать в разговоре по телетайпу, с кем он впервые разговаривает: с человеком или с машиной, в своей знаменитой статье 1950 года «Вычислительные машины и технологии». Интеллект.”

Какой бы спорной она ни была, эта статья часто рассматривается как отправная точка для дискуссий о том, где следует провести черту между людьми и машинами.

Джону Маккарти из Массачусетского технологического института приписывают изобретение «ИИ», который Марвин Мински определяет как:

«Разработка компьютерных программ, которые выполняют задачи, которые в настоящее время лучше выполняются людьми, потому что они требуют высокоуровневых умственных процессов, таких как перцептивное обучение, организация памяти и критическое мышление».

Считается, что эта дисциплина зародилась на симпозиуме, проведенном в Дартмутском колледже летом 1956 года. Как ни странно, важно отметить семинар, который стал главным событием конференции. Маккарти и Мински были двумя из шести человек, которые постоянно участвовали в этих усилиях.

В начале 1960-х годов популярность технологий снизилась, хотя они продолжали оставаться захватывающими и многообещающими. Из-за небольшого объема памяти компьютеров использование компьютерного языка было сложной задачей.

Таким образом, IPL, или язык обработки информации, позволил разработать программу LTM, которая пыталась показать математические теоремы, еще в 1956 году. решать математические теоремы.

1980-1990: Экспертные системы

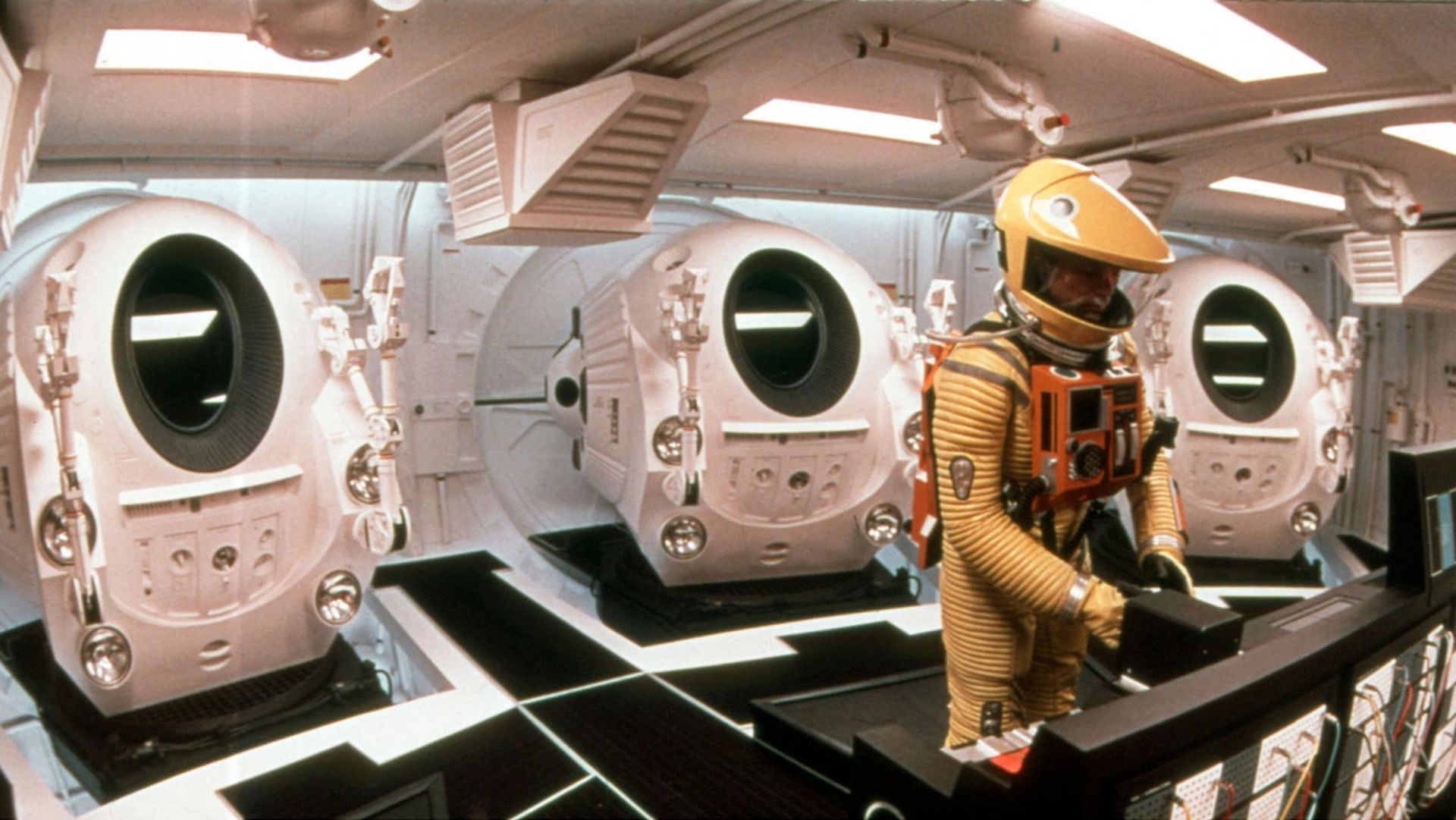

В фильме 1968 года «Космическая одиссея 2001 года», снятом режиссером Стэнли Кубриком, показан компьютер под названием HAL 9000, в котором воплощены все этические проблемы, поднятые искусственным интеллектом:

«Будет ли он очень изощренным, полезным для человечества или опасным?»

Влияние фильма, очевидно, не будет научным, но оно поможет сделать тему более известной, как писатель-фантаст Филип К. Дик, который никогда не перестанет задаваться вопросом, могут ли машины когда-либо испытывать эмоции.

Первые микропроцессоры были представлены в конце 1970-х, и экспертные системы достигли своего расцвета, когда искусственный интеллект снова стал популярным. Этот подход был обнародован в Стэнфордском университете в 1972 году с MYCIN и в Массачусетском технологическом институте в 1965 году с DENDRAL. Эти системы опирались на «механизм логического вывода», который был создан, чтобы быть логической копией человеческого мышления. Предоставляя ему информацию, движок выдавал очень компетентные ответы.

Обещания предсказывали значительный прогресс, но к концу 1980-х или началу 1990-х энтузиазм достиг пика. Потребовалось много работы, чтобы внедрить такую информацию, и между 200 и 300 правилами возникал эффект «черного ящика», скрывавший логику машины. Таким образом, создание и обслуживание стали невероятно сложными, и, что наиболее важно, появилось множество других, более быстрых, менее сложных и более доступных вариантов. Следует помнить, что в 1990-х словосочетание «искусственный интеллект» почти исчезло из академического словаря и даже появились более сдержанные формы, такие как «передовые вычисления».

В мае 1997 года суперкомпьютер IBM Deep Blue’s одержал победу над Гарри Каспаровым в шахматном матче, однако это не способствовало финансированию и развитию этого типа ИИ.

Deep Blue действовал с помощью методичного подхода грубой силы, при котором все потенциальные ходы взвешивались и оценивались. Хотя Deep Blue был способен атаковать только относительно небольшую территорию и был далек от того, чтобы имитировать сложность земного шара, поражение человека оставалось чрезвычайно символическим событием в истории.

2010-настоящее время: современная эра ИИ

Технологии искусственного интеллекта, которые оказались в центре внимания после поражения Каспарова от суперкомпьютера Deep Blue, достигли своего пика в середине 2010 года. Два фактора могут объяснить новый бум в этой дисциплине в 2010 году:

- Доступ к огромным объемам данных

- Открытие процессоров компьютерных графических карт, которые работают с чрезвычайно высокой эффективностью.

Общественные достижения, ставшие возможными благодаря этой новой технологии, привели к увеличению инвестиций, и Watson, искусственный интеллект IBM, победит двух чемпионов Jeopardy в 2011 году.

Благодаря Google X в 2012 году искусственный интеллект сможет распознавать кошек на видео. Эта последняя задача потребовала использования более 16 000 процессоров, но потенциал машины, которая может научиться различать разные вещи, был поразительным.

В 2016 году Ли Седол и Фан Хуэй, чемпионы Европы и мира по играм в го, проиграют AI AlphaGO от Google.

Откуда взялось это чудо? Радикальный отход от экспертных систем. Методология изменилась и стала индуктивной; вместо правил кодирования, как в случае с экспертными системами, теперь необходимо позволить компьютерам самостоятельно обнаруживать их посредством корреляции и категоризации на основе огромных объемов данных.

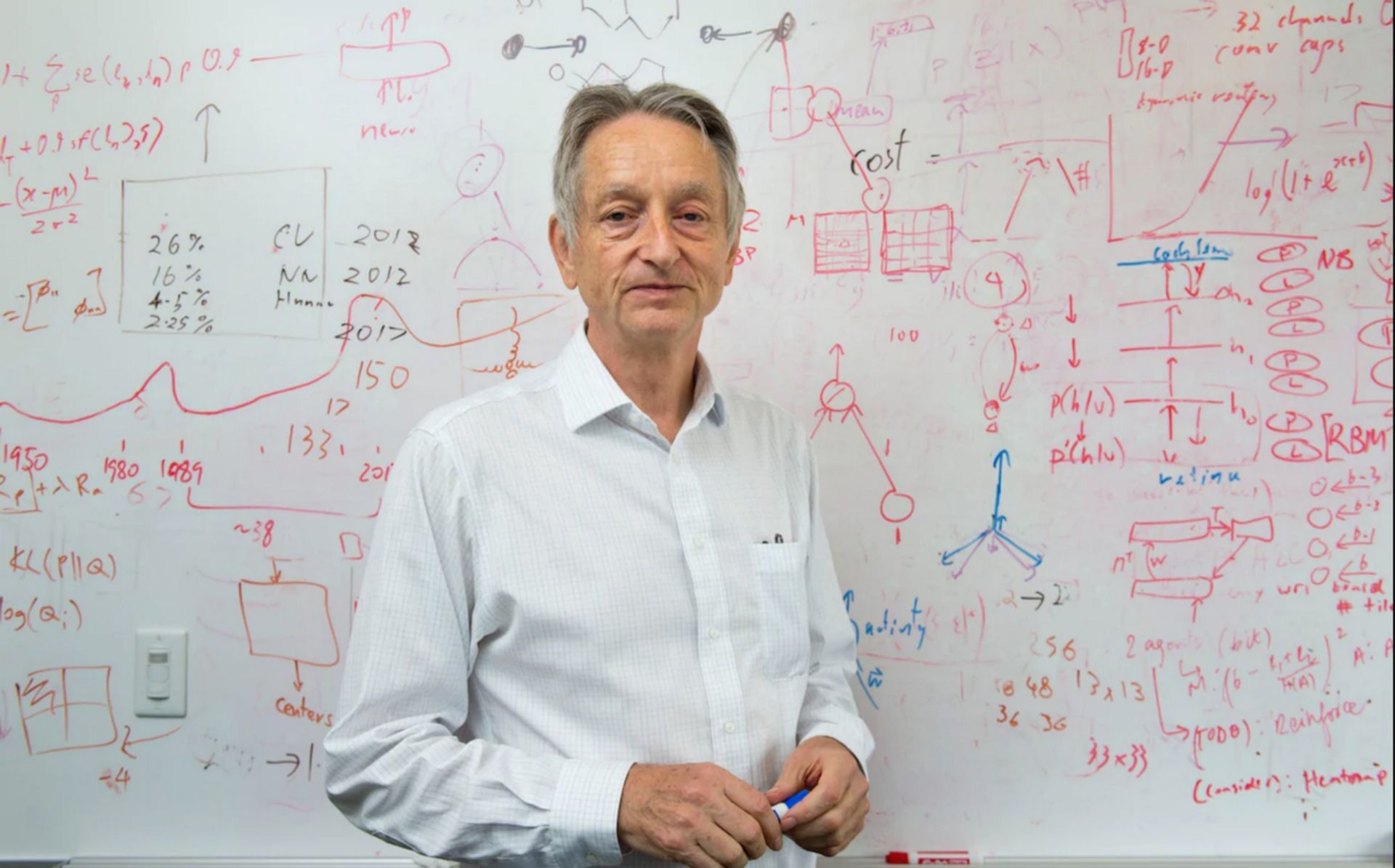

Глубокое обучение кажется наиболее многообещающей технологией машинного обучения для различных приложений. В 2003 году Джеффри Хинтон, Йошуа Бенжио и Ян ЛеКун решили запустить исследовательскую программу по модернизации нейронных сетей. При содействии лаборатории Торонто эксперименты, проводившиеся одновременно в Майкрософт, Googleа также IBM показали, что этот вид обучения был успешным в снижении частоты ошибок при распознавании речи наполовину. Команда распознавания изображений в Hinton добилась такого же успеха.

Практически в одночасье подавляющее большинство исследовательских групп переняли эту технологию, имевшую неоспоримые преимущества. Несмотря на значительное улучшение распознавания текста благодаря этой форме обучения, по словам таких специалистов, как Янн Лекун, еще предстоит пройти долгий путь, прежде чем можно будет создать системы распознавания текста.

Диалоговые агенты являются хорошей иллюстрацией этой трудности: хотя наши смартфоны в настоящее время способны расшифровывать инструкции, они не могут должным образом контекстуализировать их или распознавать наши намерения.

Вот как мы резюмировали для вас развитие технологий ИИ на сегодняшний день. Продолжайте читать нас, чтобы быть в курсе последних новостей о технологиях искусственного интеллекта, таких как Notion AI и Meta Galactica AI.

Source: Как долго существует ИИ: объяснение истории искусственного интеллекта