За последние годы искусственный интеллект (ИИ) добился невероятных успехов. Тем не менее, понимание того, что такое галлюцинация ИИ и как ее преодолеть, все еще является продолжающимся процессом для создателей LLM.

Технологии сегодняшнего и завтрашнего дня продолжают очаровывать нас всех, особенно когда речь идет о том, как ИИ может понимать и генерировать человеческий язык. Огромный прогресс был достигнут с помощью моделей большого языка (LLM) — компьютерных программ, обучающихся на огромных объемах текста. Эти LLM могут писать различные творческие текстовые форматы, такие как стихи, коды, сценарии, музыкальные произведения, электронную почту, письма и т. д.

Однако с мощностью этих впечатляющих моделей возникает своеобразная проблема – они иногда «галлюцинируют».

Что такое галлюцинация ИИ?

Точно так же, как люди могут воображать или выдумывать нереальные вещи, ИИ может делать нечто подобное. Галлюцинации ИИ случаются, когда LLM создает текст, который кажется правдоподобным, но на самом деле неверен. Эти галлюцинации могут варьироваться от незначительных ошибок до полностью выдуманных историй и бессмысленных утверждений.

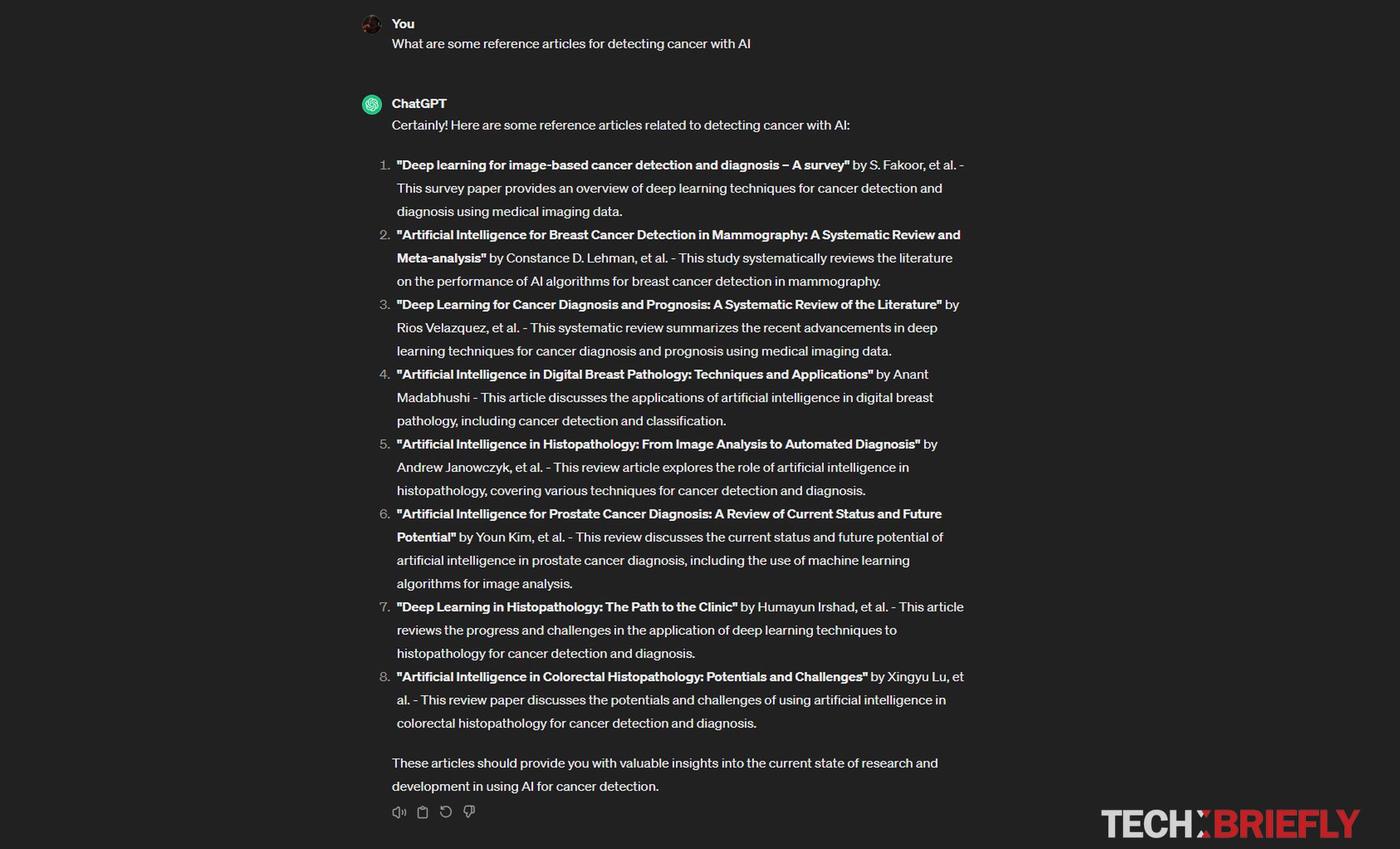

Чтобы лучше разобраться в этом вопросе, давайте рассмотрим несколько примеров:

- Смешение фактов: ИИ, которого попросили написать новостную статью о событии, может указать неверные даты и места или исказить участников.

- Создание ложных информация: ИИ, которому поручено написать описание продукта, может изобрести функции, которых на самом деле у продукта нет.

- Уверенно неверно: Самая сложная вещь в галлюцинациях ИИ заключается в том, что они часто представлены в очень убедительной форме, из-за чего их трудно отличить от реальной информации.

Почему галлюцинации являются проблемой для студентов-магистров?

Как вы можете видеть из наших объяснений того, что такое галлюцинации ИИ, они представляют собой серьезную проблему для студентов-магистров по нескольким причинам. Во-первых, если люди не могут доверять тексту, который генерирует LLM, пользователи теряют веру в общую полезность и надежность технологии. Представьте, что вы читаете онлайн-резюме новости, написанной LLM. Если резюме содержит фактические ошибки, вы можете вообще отказаться от использования этого источника. Это может стать серьезной проблемой для любого приложения, которое использует LLM для генерации текста, например чат-ботов, виртуальных помощников или инструментов автоматического создания контента.

Во-вторых, галлюцинации ИИ могут способствовать распространению дезинформации. В эпоху, когда фейковые новости уже являются серьезной проблемой, сгенерированный ИИ текст, который кажется правдоподобным, легко может быть принят за реальную информацию. Это может оказать негативное влияние на все: от общественного обсуждения до важных процессов принятия решений. Например, представьте себе, что LLM создает в социальных сетях посты о политическом кандидате, содержащие ложную информацию.

Эти посты могут ввести избирателей в заблуждение и повлиять на исход выборов. Это точная причина, по которой Google отключил возможность Gemini отвечать на запросы, связанные с выборами.

В-третьих, предприятия или организации, использующие LLM, могут столкнуться с репутационным ущербом, если их системы искусственного интеллекта создают неточный или вредный контент. Допустим, компания использует LLM для написания описаний товаров для своего интернет-магазина. Если LLM изобретает функции, которых на самом деле нет в продуктах, это может привести к недовольству клиентов и нанести ущерб репутации компании.

Почему случаются галлюцинации ИИ?

У вас есть некоторые идеи о том, что такое галлюцинации ИИ сейчас, но почему они происходят? Этой проблеме способствуют несколько факторов:

- Как их обучают: LLM получают огромные объемы текстовых данных. Эти данные часто содержат ошибки, предвзятость и устаревшую информацию. ИИ учится на этих данных так же, как на правильной информации.

- Понимание против создания: Магистр права хорошо разбирается в языковых закономерностях, но не всегда хорошо понимает концепции и логику реального мира. Они могут генерировать что-то, что звучит правдоподобно, но на самом деле это не соответствует действительности.

- Стремление к беглости: LLM предназначены для создания текста, который звучит естественно и по-человечески. Иногда это означает «заполнение пробелов» там, где могут быть пробелы в знаниях ИИ. Эти заполненные пробелы могут привести к тому, что ИИ создаст контент.

Что делается для решения этой проблемы?

Исследователи и разработчики в сообществе ИИ активно работают над способами уменьшения галлюцинаций ИИ.

Некоторые из подходов включают в себя:

- Лучшие данные тренировок: Создание тщательно подобранных наборов данных, которые с меньшей вероятностью будут содержать ошибки и предвзятости, что приведет к улучшению поведения ИИ.

- Проверка фактов: Разработка методов перекрестных ссылок текста, созданного ИИ, на надежные источники, обеспечивающего его точность.

- Объясняемость: Разработка LLM, которые могут объяснить процесс их рассуждения, что облегчает обнаружение потенциальных ошибок.

- Сотрудничество человека и искусственного интеллекта: Создание систем, в которых люди и искусственный интеллект работают вместе, что упрощает выявление и исправление галлюцинаций.

Помимо всего этого, Дженсен Хуанг из Nvidia утверждает, что галлюцинации искусственного интеллекта можно вылечить в течение следующих 5 лет.

Итак, галлюцинации ИИ — сложная проблема, но ее крайне важно преодолеть, если студенты магистратуры хотят полностью раскрыть свой потенциал. Поскольку технологии уменьшения галлюцинаций становятся все более сложными, они обещают сделать LLM гораздо более надежным и ценным инструментом для общения, творчества и познавательных задач.

Автор избранного изображения: vackground.com/Unsplash